更多AI前沿科技资讯,请关注我们:

【closerAI ComfyUI】好玩实用!色彩控制与迁移,让AI生图色彩实现可控,可,设计、摄影等调色场景都能用到!

大家好,我是Jimmy。这期我们主要讨论如何使用stable diffusion comfyUI 制作色彩控制与迁移的工作流,让我们生图的结果能按照我们的调调来。节点和工作流都很实用哦。

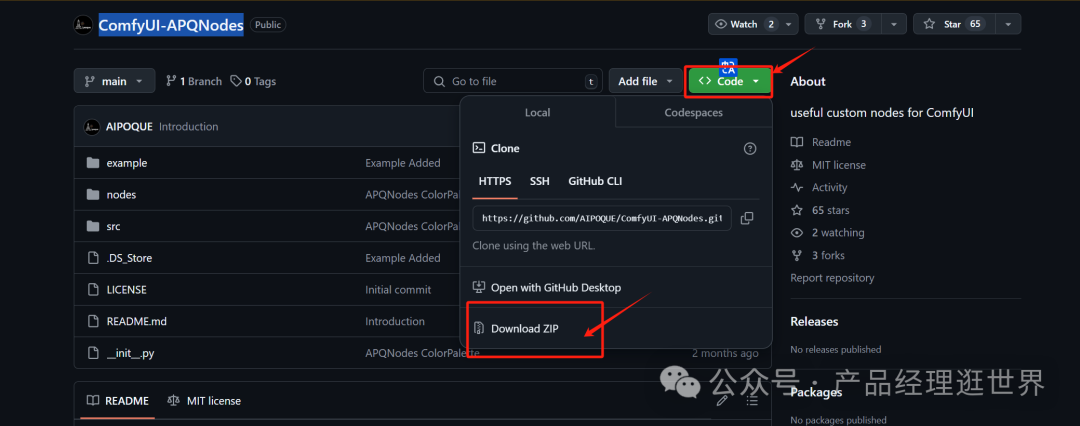

这期工作流,主要使用到下点:ComfyUI-APQNodes

githug地址:https://github.com/AIPOQUE/ComfyUI-APQNodes

直接下载解压:

放到以下路径:

节点安装很简单,里就不展开了。像以上操作即可。

ComfyUI APQNodes中的“颜色名称”节点将输入的十六进制颜色代码转换为FLUX.1 Dev知道的最相似的颜色名称(来自预先测试的155个颜色名称),也就是,它形成的16进制的代码,flux模型不一定看得懂,但它会转化成最相似的颜色。也就是说颜色会存在一点出入。

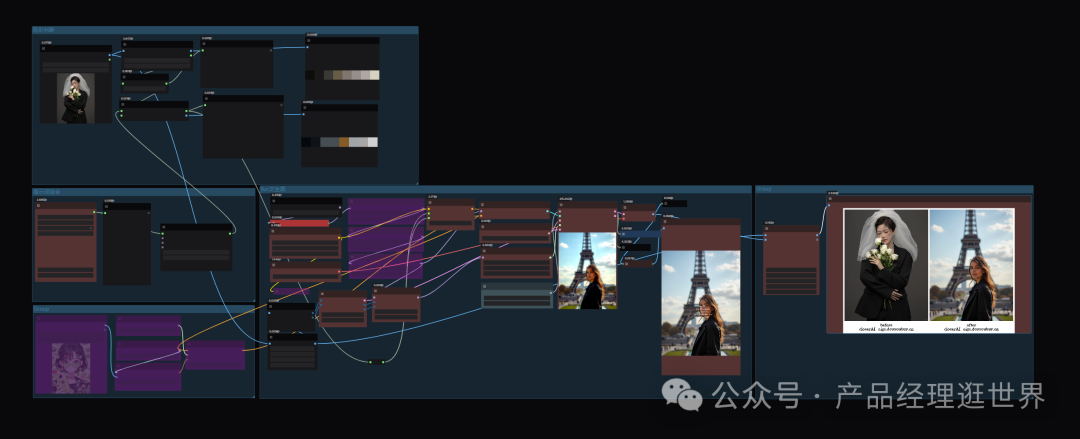

closerAI flux 色彩控制与迁移工作流

然后加载我们closerAI开发的closerAI flux 色彩控制与迁移工作流

主要思路:加载一张色彩参考图,反推出图片色彩,对色彩进行控制,然后连同提示词加入一起生图。

工作流主要抛砖引玉啦,主要演示色彩控制和迁移生图。它能加入在以前的工作流进行使用,当然前提是你对生图的色彩有要求啦。如果没有就让模型自由发挥了。注意这里工作流还是围绕flux。

工作流中另一个主要的模块是redux风格参考模块,redux也介绍过了,这里不展示,没看的可以看看相关文章:

【closerAI ComfyUI】flux redux控制不了?这个方法教会你完美释放风格模型的能力,实现完美的风格迁移,推荐

为了演示,工作流中固定了种子,大致生成的内容控制一样来进行演示。

我提示词写:一个美女站在埃菲尔铁塔下

加载的色彩参考图是:

效果如下:

上面是加载的参考图,中间是识别出来的色彩,下面是根据色彩来生图的结果。

我们再试一次,加载色彩参考图:上面是加载的参考图,中间是识别出来的色彩,下面是根据色彩来生图的结果。

图结果如下:

尽管目前这个节点的色彩迁移具有局限性,颜色会有色差。如果对生图结果的色彩要求不高,这个节点就满足使用。如果高,也不怕,其实它提供了一个思路给我们,就是在提示词中控制颜色,也一样能达到色彩控制与迁移的效果。手动提示词更为可控。

以下是我自己填的一个颜色,红色、黄色、绿、黑。的生图结果:

如果要更为精准,使用大语言模型反推:

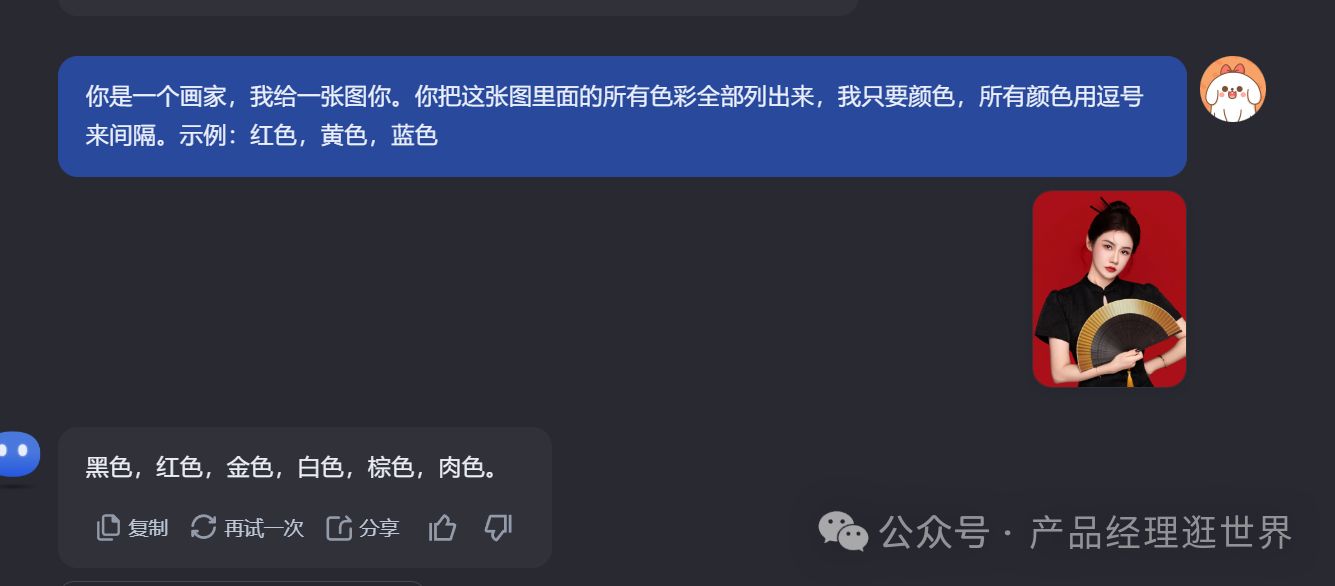

手动提示词的实现思路:打开AI大模型,这里用KIMI,输入:

你是一个画家,我给一张图你。你把这张图里面的所有色彩全部列出来,我只要颜色,所有颜色用逗号来间隔。示例:红色,黄色,蓝色

得出:黑色,红色,金色,白色,棕色,肉色。

生图结果如下:

我们在提示词准备过程中,可以构思大概的色彩,像人物衣服什么颜色,头发什么颜色,直接描述进去。

所以,我提示词这样写:

一个美女站在埃菲尔铁塔下,画面的色彩要求:颜色仅限于以下几种颜色,包括:黑色,红色,金色,白色,棕色,肉色。其中,衣服为绿色,头发为红色,天空为蓝色

以下是生图结果:

结论:

1、ComfyUI-APQNodes 能快速反推出图像的色彩, 我们减少了生图过程中颜色的提示词描述。但它的缺点是色彩会转化成flux模型能理解的颜色代码,所以会有出入。

2、根据ComfyUI-APQNodes的思路,我们手动输入颜色来控制。可通过使用AI 助手来反推出图像所有色彩,当然得到的还是模糊的不精准的大致色彩。

3、根据以上思路,可将色彩反推节点接下不同工作流,实现色彩控制。像我们这次的工作流接入了redux。可玩性高。

以上是closerAI团队制作的stable diffusion comfyUI closerAI开发的closerAI flux 色彩控制与迁移工作流介绍,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流。

更多AI前沿科技资讯,请关注我们:

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)