更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

【closerAI ComfyUI】彻底疯狂!6G显存就能生成1分钟视频!FramePack技术拯救消费级显卡,普及从这一刻开始

大家好,我是Jimmy。2025年开源界的视频生成赛道依然卷,我追我赶从未停下脚步。这次历史时刻,让消费级的显卡,也能高效生成长达1分钟的视频。直接把其它开源视频生成模型打下。

FramePack项目介绍

仓库地址:https://github.com/lllyasviel/FramePack

项目来自敏神,开源了FramePack项目,它是一种面向视频生成的“下一帧(或下一帧片段)预测”神经网络结构,旨在通过压缩输入帧的上下文信息,使视频生成的计算负载与视频长度无关。其核心目标是让视频扩散模型(video diffusion)在消费级GPU(如笔记本显卡)上实现长视频生成,并提升训练效率。

说人话就是,它能像“自动补全”一样,根据你给的图片和一句话描述,生成连续动态的视频。比如你上传一张人站着的图,写“他在跳舞”,它就能生成这人跳舞的动画。

1、核心技术与创新

- 上下文压缩机制 将输入帧的上下文压缩为固定长度,确保生成工作量不随视频长度增加,支持处理超长视频(如60秒/1800帧)。 在低显存设备(如6GB显存的笔记本GPU)上运行13B参数模型。

- 性能优势 生成速度:RTX 4090可达1.5秒/帧(优化后)或2.5秒/帧(未优化);笔记本GPU(如3060)速度慢4-8倍。 训练效率:支持与图像扩散模型相当的大批量训练,降低显存占用。

- 实时生成反馈 逐帧或逐片段生成,用户可实时预览生成过程,无需等待完整视频生成。

2、硬件与软件需求

硬件GPU:NVIDIA RTX 30XX/40XX/50XX系列(支持fp16/bf16),显存≥6GB(GTX 10XX/20XX未测试)。

系统支持Linux/Windows,需Python 3.10环境。

依赖库PyTorch、Gradio等(支持多种注意力优化选项:xformers、flash-attn、sage-attention)。

3、硬件与软件需求

comfyUI FramePack的安装与体验

在comfyUI中有两个节点可以实现Framepack项目。

分别如下:

https://github.com/HM-RunningHub/ComfyUI_RH_FramePack

https://github.com/kijai/ComfyUI-FramePackWrapper

两个节点均能实现敏神FramePack项目。我们分别看看安装。

1、ComfyUI_RH_FramePack安装

首先先根据上面地址,把节点下载解压放置节点文件夹中。

然后下载混元视频模型、FLUX REDUX BLF模型、FramePackI2V模型,如下,分别分置对应路径中。

1. HunyuanVideo Model

Local Path: /workspace/comfyui/models/HunyuanVideo

Download Source: HunyuanVideo on HuggingFace

https://huggingface.co/hunyuanvideo-community/HunyuanVideo/tree/main

2. Flux Redux BFL Model

Local Path: /workspace/comfyui/models/flux_redux_bfl

Download Source: flux_redux_bfl on HuggingFace

https://huggingface.co/lllyasviel/flux_redux_bfl/tree/main

3. FramePackI2V Model

Local Path: /workspace/comfyui/models/FramePackI2V_HY

Download Source: FramePackI2V_HY on HuggingFace

https://huggingface.co/lllyasviel/FramePackI2V_HY/tree/main

2、ComfyUI-FramePackWrapper安装

首先先根据上面地址,把节点下载解压放置节点文件夹中。

使用文本编码器、VAE和sigclip的所有原生模型,也就是一般玩过wan2.1、FLUX,都已经有了,直接下载FramePackI2V的视频生成模型即可。当然,这个FramePack是基于混元视频生成模型的。

使用文本编码器、VAE和sigclip的所有原生模型:

https://huggingface.co/Comfy-Org/HunyuanVideo_repackaged/tree/main/split_files

https://huggingface.co/Comfy-Org/sigclip_vision_384/tree/main

Transformer模型本身可以从这里自动下载:

https://huggingface.co/lllyasviel/FramePackI2V_HY/tree/main

ComfyUI\models\diffusers\lllyasviel\FramePackI2V_HY

或者从单个文件,在ComfyUI\models\diffusion_models中:

安装后,重启ComfyUI。

以下两个节点都可安装,KJ版工作流节点会多一点,RH版节点少一点,简单一点。大家根据情况安装。

下面我们体验一下。

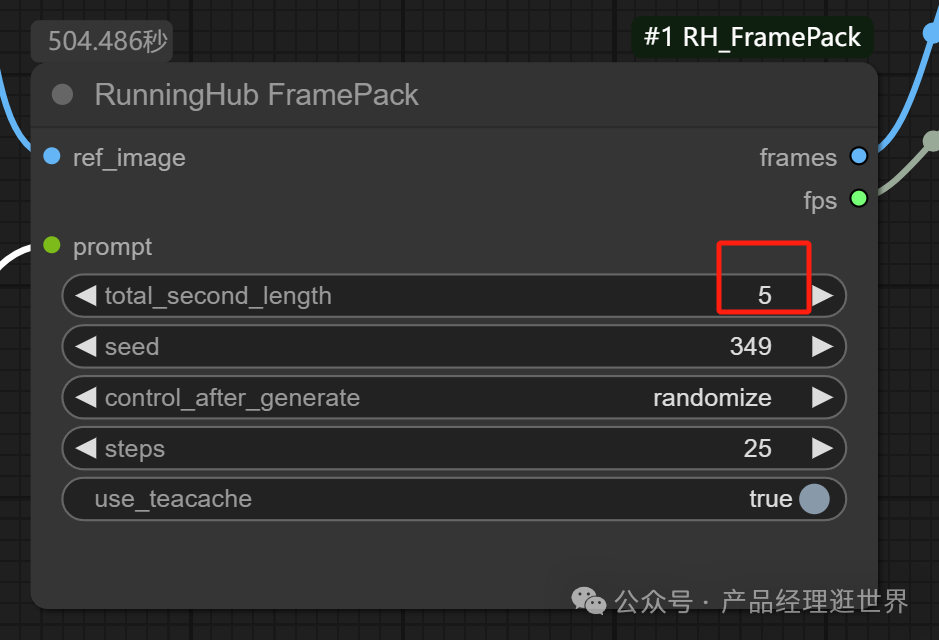

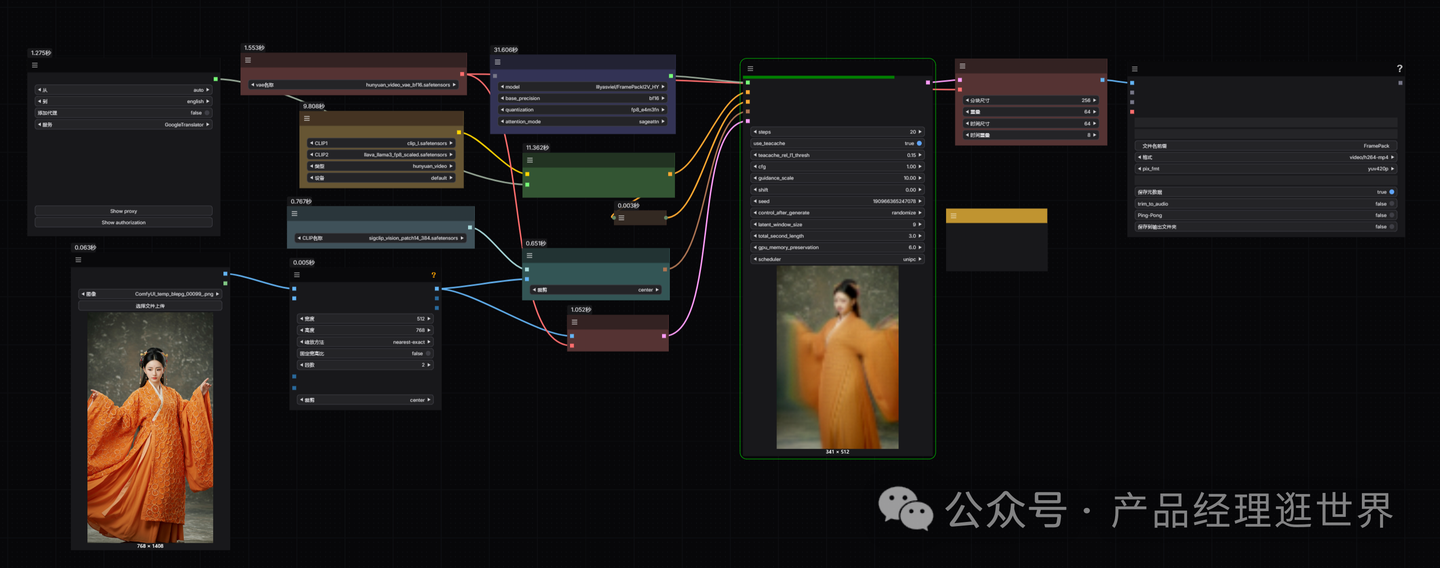

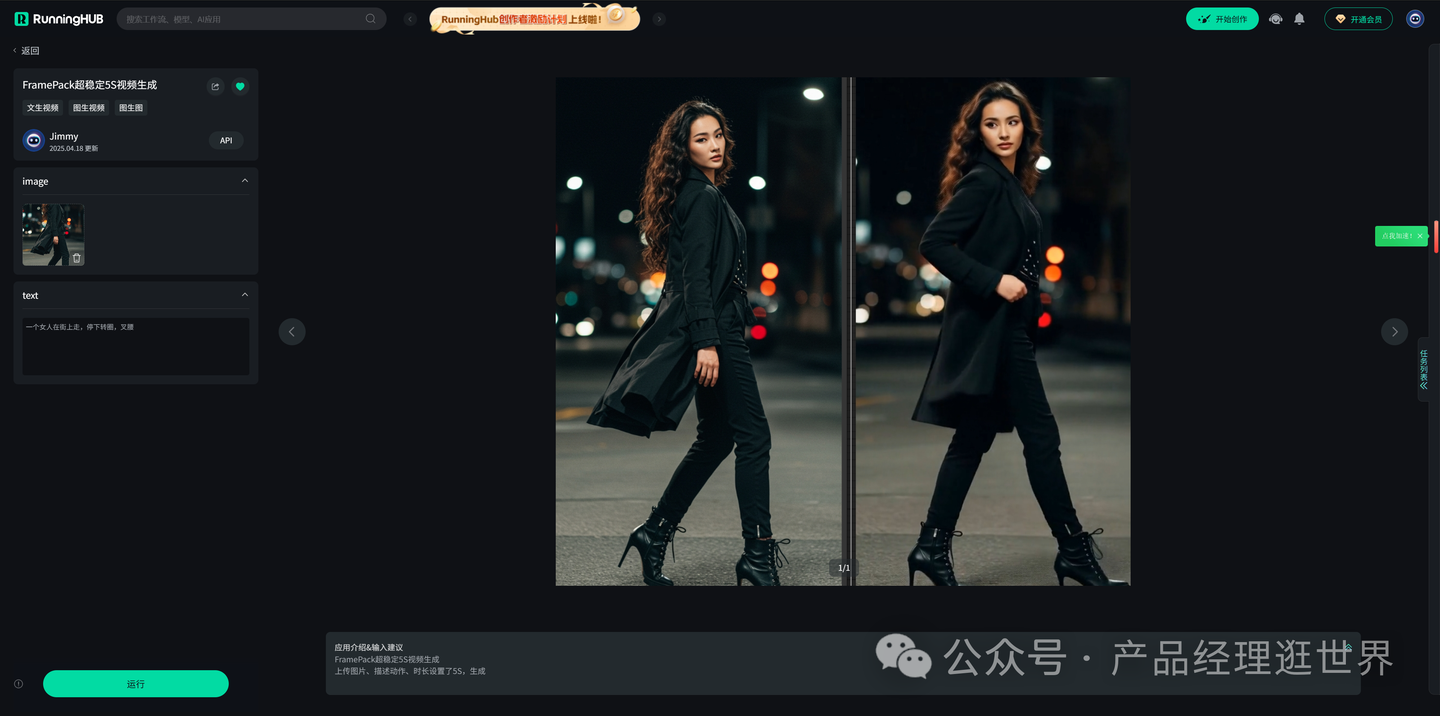

首先先看RH版的FramePack。工作流较为简单了,如下图示。

加载一张图,提示词写一个:一个女人在跳舞,旋转后坐下。总时长设置在5S,跑了8分多钟。

没旋转起来。

再搞一个:这个女孩跳得很有活力,在空中跳跃,手臂摆动流畅,脚步很快。

可以看见,两个视频生成的效果非常稳定!完全没有崩,动作连贯。可以说是在动作幅度大的情况比万相更加稳定、质量更加好。

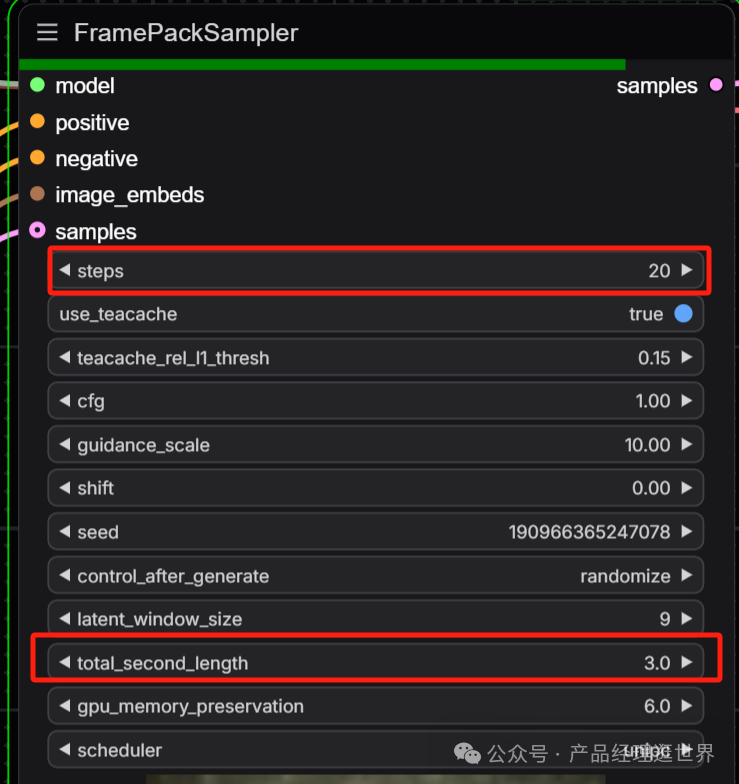

下面看KJ版本:

主要设置时长和步数,其它默认即可。

以下是跑出来的一些结果:

本地算力不够怎么办?

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

runninghub.cn FramePack超稳定5S视频生成体验地址:

https://www.runninghub.cn/ai-detail/1913039250726813698

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

FRAMPACK这个项目基于混元视频生成模型,通过这个技术,让视频生成在低显存的显卡上也能生成稳定的质量高的最多一分钟的视频。这绝对是吊打了市面上开源和闭源的产品,这些产品都是5S、8S,但这个技术直接给你搞到60S。速度快,质量好,生成稳定不崩!基于这个,消费级显卡也能充当生产力工具!

以上FramePack项目的介绍、安装和体验,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)