更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

【closerAI ComfyUI】厉害!动画、视频、电影都能搞!UniAnimate万相Lora简单高效实现动画效果!无脑冲!

大家好,我是Jimmy。阿里团队基于万相2.1视频生成模型推出人物动画LORA,简化了动作迁移的工作流程,只需要接入LORA和撰写简单提示词即可完成高质量的人物动作迁移的视频,相当于只需要找到动作,它就可以驱动指定人物去模仿这个动作。动画、视频、电影都能搞!你就说屌不屌!

UniAnimate项目介绍

仓库地址:https://github.com/ali-vilab/UniAnimate

论文地址:https://unianimate.github.io/

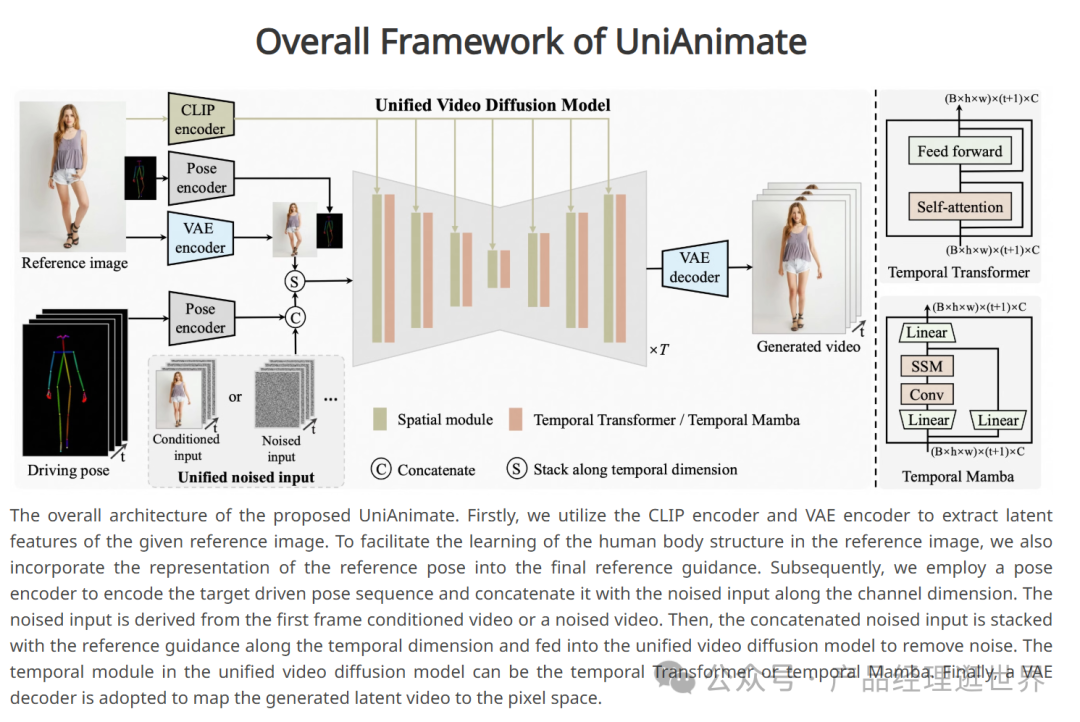

UniAnimate统一视频扩散模型用于一致的人类图像动画

UniAnimate 旨在通过统一的视频扩散模型实现一致的人类图像动画。该研究解决了现有技术的两个主要限制:需要额外的参考模型来对齐身份图像以及生成的视频较短。通过引入统一的噪声输入和基于状态空间模型的时间建模架构,UniAnimate 能够生成高质量、长时间的人类视频。

UniAnimate 框架

为了解决这些问题,UniAnimate 提出了以下创新:

- 统一的特征空间映射:通过将参考图像、姿势引导和噪声视频映射到一个共同的特征空间,减少了优化难度并确保了时间一致性。

- 统一的噪声输入:支持随机噪声输入和第一帧条件输入,增强了生成长期视频的能力。

- 基于状态空间模型的时间建模:替代了计算消耗大的时间变换器,以更高效地处理长序列。

UniAnimate的comfyUI实现

KJ大神已复现了这个功能,大家更新KJnodes即可。

Kjwanvideo:https://github.com/kijai/ComfyUI-WanVideoWrapper

模型下载:https://huggingface.co/Kijai/WanVideo_comfy/tree/main

模型下载后放置:comfyUI/models/loras中

更新和下载完模型后重启comfyUI,拖入我们的工作流:

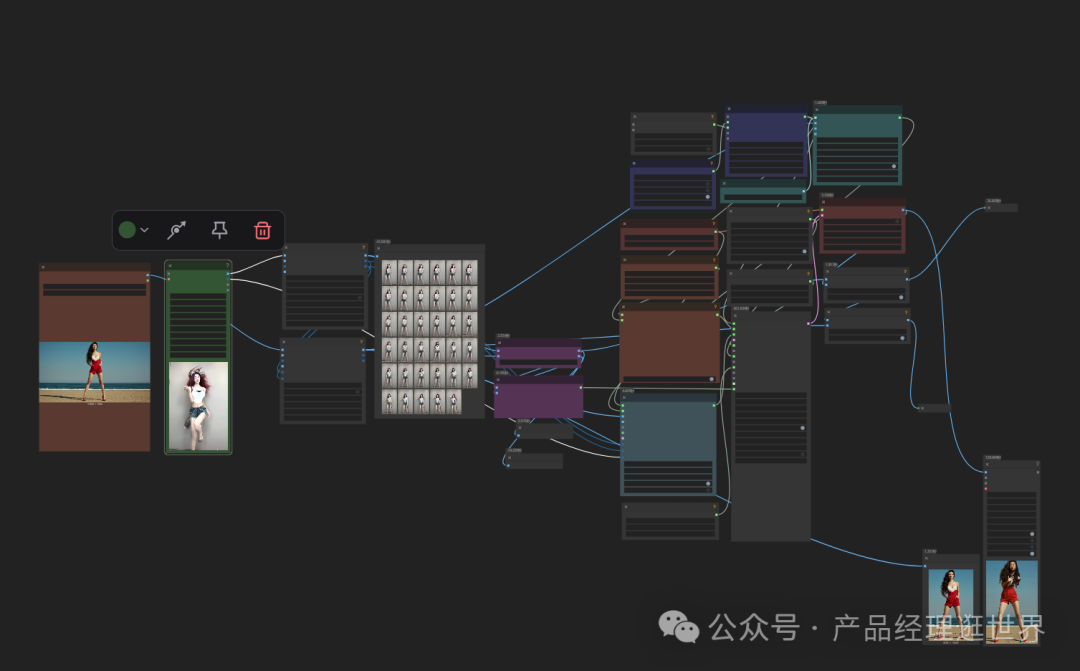

closerAI UniAnimate wan lora 人物动画工作流

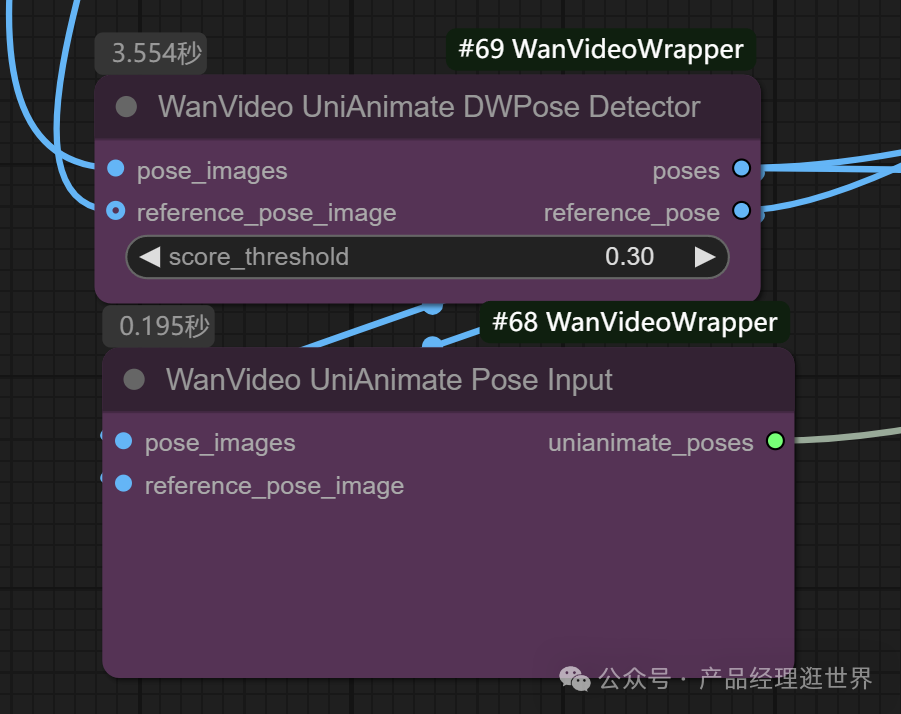

在wan2.1的基础视频生成工作流中加入最新支持UniAnimate的节点。

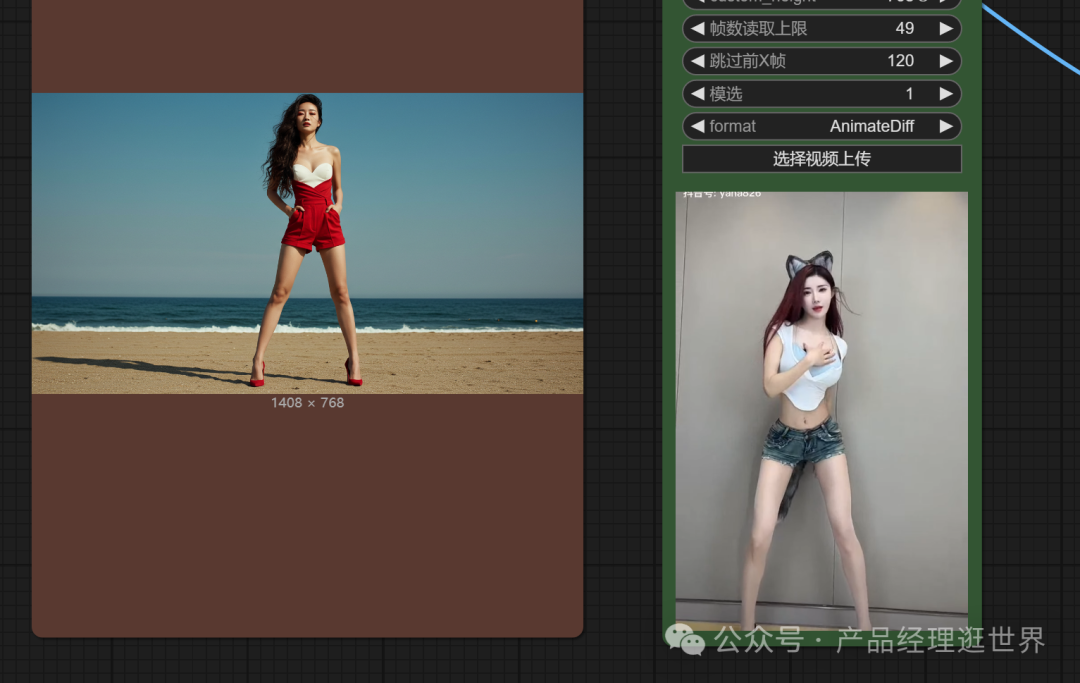

加载一张人像图和一段动作舞蹈:左边是图,右边是参考动作视频

然后无脑执行。

执行完效果:

我的设备配置低,跑了很久,搞了个1S的。效果如上。大家作参考吧。

本地算力不够怎么办?

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

runninghub.cn一图跳舞工作流体验地址:

https://www.runninghub.cn/ai-detail/1913774392671727617

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

一个LORA就能实现动作迁移,简化了以往的工作流程,让你出片更高效!可玩性和市场价值非常高。

以上是UniAnimate万相Lora的介绍、安装和使用方法以及closerAI团队制作的stable diffusion comfyUI closerAI开发的closerAI UniAnimate wan lora 人物动画工作流介绍,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)