更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

轨迹控制!字节继续搞活!字节ATI项目:任意轨迹指令驱动的可控视频生成技术,绘制运动轨迹,万物即可控制!效果不错,推荐!

大家好,我是Jimmy。最近字节跳动又搞活,推出一个可以控制主体轨迹的视频生成框架。效果不错。一起来看看。

ATI:任意轨迹指令驱动的可控视频生成技术

—— 统一物体、局部与相机运动的下一代视频生成框架

ATI(Any Trajectory Instruction) 是由字节跳动智能创作团队研发的轨迹控制视频生成框架。它通过用户绘制的轨迹指令,精准控制视频中物体运动、局部形变和相机运镜,将三者统一于同一生成流程,显著提升视频生成的动态可控性与视觉质量。

核心创新

1.统一运动控制:

- 物体运动(如飞鸟轨迹)、局部形变(如布料飘动)、相机运动(推拉/平移)均可通过轨迹指令控制。

- 支持自由绘制轨迹、静态锚点、环形缩放轨迹(模拟变焦)等多种指令模式。

2.轻量级运动注入器

- 基于高斯分布的运动注入模块,将轨迹编码为潜空间特征,无缝嵌入预训练视频扩散模型(如Wan2.1)。

- 无需重新训练整个模型,兼容主流图像到视频(I2V)框架。

3.高保真生成效果

- 轨迹指令与生成内容语义对齐,运动连贯自然,优于现有开源方案及商业工具(如Pika、Runway)。

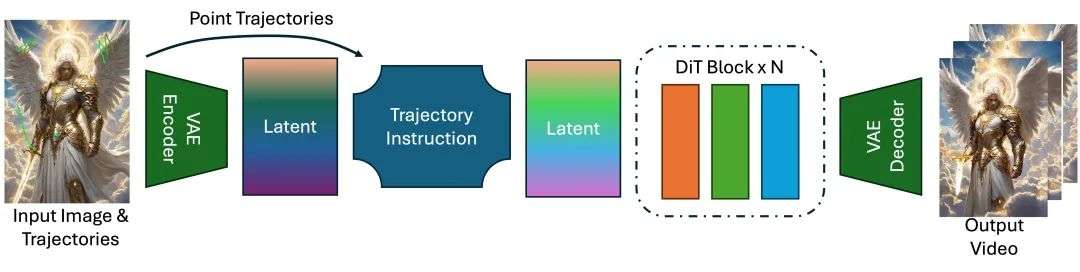

技术原理

1.输入:静态图像 + 用户绘制的轨迹(定义关键点路径)。

2.轨迹编码:轨迹指令模块将路径转化为时空高斯特征图,通过双线性插值注入扩散模型潜空间。

3.可控生成:扩散模型(DiT)根据轨迹特征生成动态潜变量,解码为符合指令的视频帧序列。

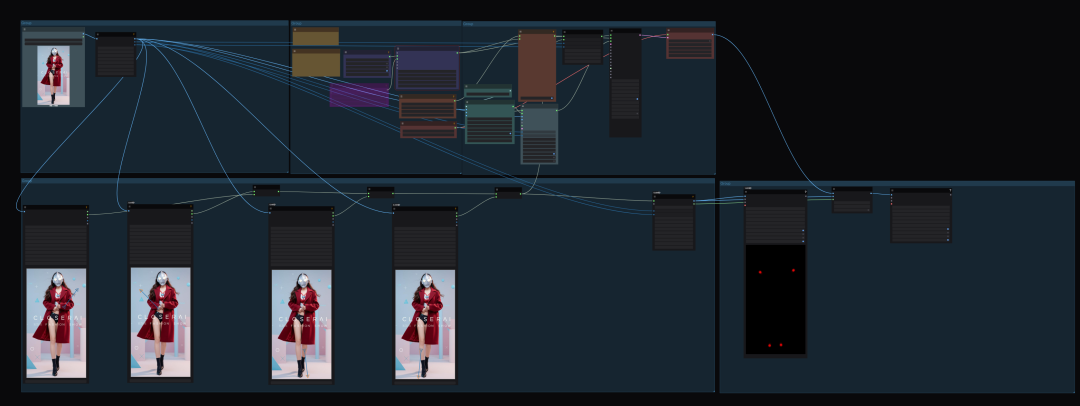

AIT 在comfyUI中的实现与体验

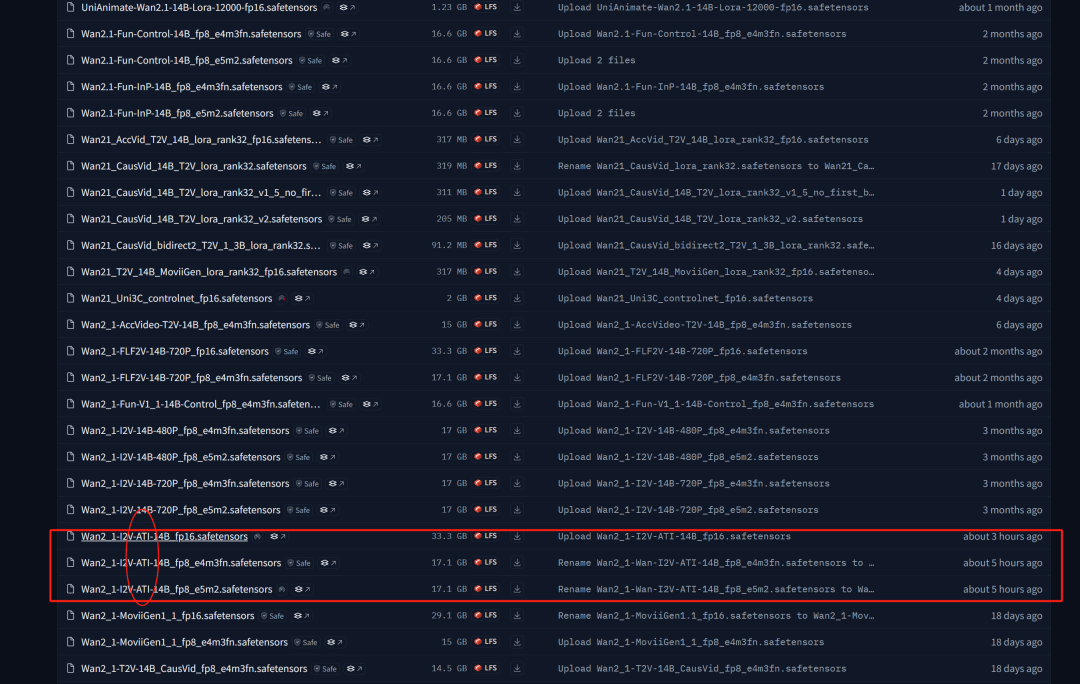

目前,KJ大佬已量化了该项目的模型,并在近两天发布出来了。大家可以在他的抱脸仓库上下载对应模型,如下图示:

https://hf-mirror.com/Kijai/WanVideo_comfy/blob/main/Wan2_1-I2V-ATI-14B_fp8_e4m3fn.safetensors

我们下载:Wan2_1-Wan-I2V-ATI-14B_fp8_e4m3fn.safetensors

下载后放置在以下路径中:comfyUI\models\diffusion_models

然后,更新KJ的wanVideo节点:https://github.com/kijai/ComfyUI-WanVideoWrapper 下载后覆盖原来的节点即可。重启comfyUI。

加载工作流:

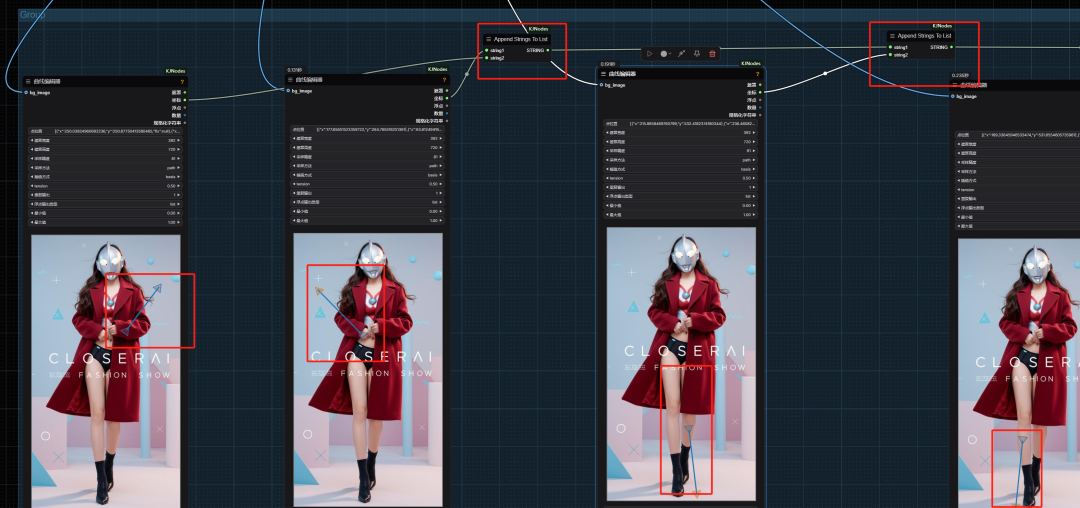

工作流中,主要的新增节点是,曲线编辑器

添加曲线,移动即可。

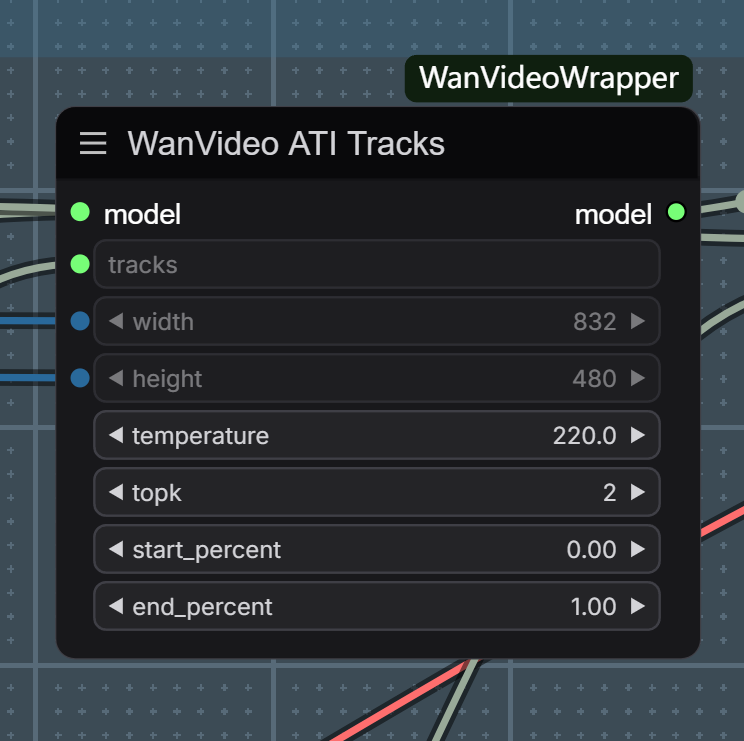

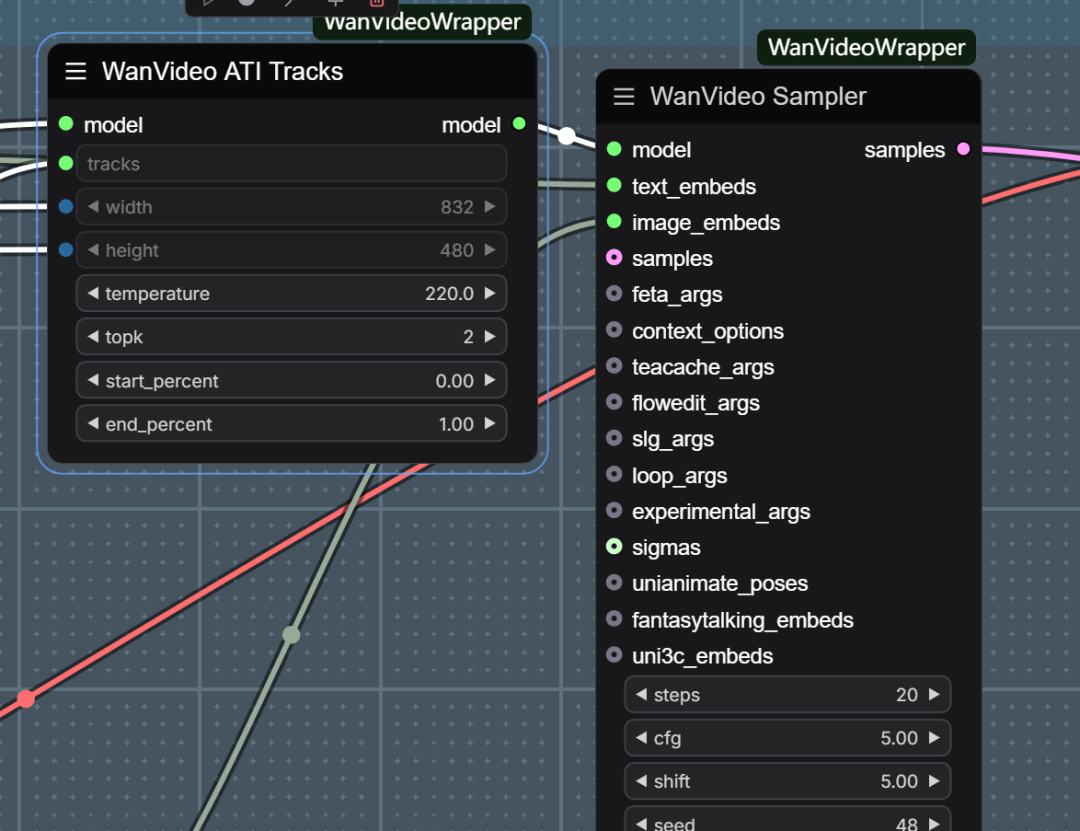

以及ATI Tracks节点

接法如下:

本地算力不够怎么办?

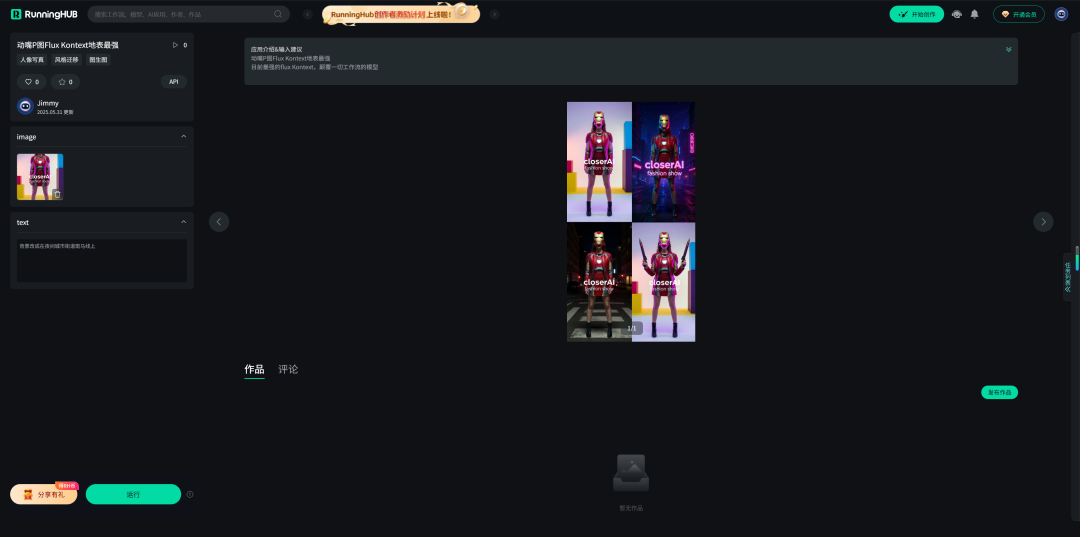

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

runninghub.cn 动嘴P图Flux Kontext地表最强体验地址:

https://www.runninghub.cn/ai-detail/1928637666924072961

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

用户手绘任意轨迹,AI即可精准驱动物体运动、局部形变与镜头运镜(推拉/平移),三大控制统一实现;无需专业门槛,可将静态图转为电影级动态视频,开源突破商业垄断,让视频生成从“语言描述”时代迈入“轨迹编程”时代!

以上是字节ATI项目介绍、安装与体验。以及closerAI团队制作的stable diffusion comfyUI closerAI wan2.1 AIT轨迹控制视频生成工作流介绍,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)