更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

【closerAI ComfyUI】超赞!轻松制作电影级别特效!万相controlnet模型Uni3C,精确控制摄像机和人体运动!

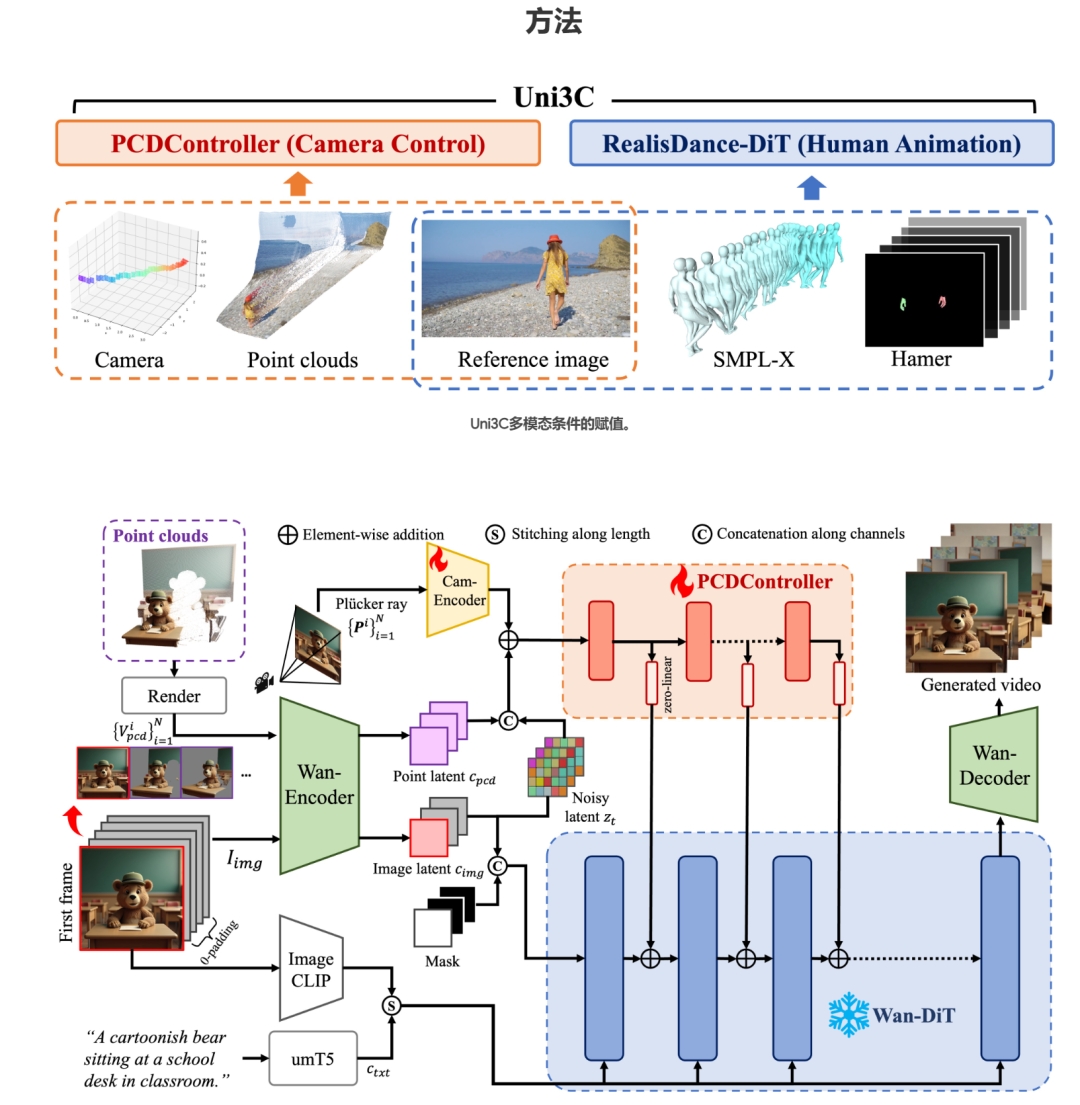

大家好,我是Jimmy。今天介绍一个基于万相视频模型的controlnet模型:Uni3C。Uni3C,一个统一的3D增强框架,用于在视频生成中精确控制摄像机和人体运动。

Uni3C: 统一3D增强的相机与人体运动控制视频生成框架

核心创新:Uni3C 首次实现了单视角图像到视频生成中相机轨迹与人体运动的联合精准控制,无需联合训练数据,支持跨领域(真实场景、AI生成、动画)的多样化视频生成。

项目链接:https://github.com/ewrfcas/Uni3C

技术突破

1、模块化设计

- PCDController:基于点云的即插即用控制模块。通过单目深度估计生成未投影点云,驱动任意相机运动(如环绕、俯仰、平移等)。兼容冻结或微调的视频生成主干模型(如Stable Video Diffusion),无需联合训练即可泛化至不同领域。

- 全局3D世界对齐:将场景点云与SMPL-X人体模型在3D空间对齐,统一相机与人体运动控制信号,实现自然交互(如人物行走时的动态跟拍)。

2、数据效率与灵活性

分模块训练策略减少对高标注质量数据的依赖,相机控制与人体运动模块可独立优化。支持相机控制运动迁移:将现有视频中的相机运动迁移至新场景或角色。

应用场景

- 影视预演:快速生成多视角动态分镜。

- 虚拟制作:实时控制动画角色的运动与镜头语言。

- 游戏开发:自动生成角色动作与镜头轨迹的多样化组合。

性能优势

- 精准控制:在复杂相机轨迹(如360°环绕)和剧烈人体动作(如舞蹈)下保持稳定性。

- 跨域泛化:适配真实图像、文本生成图像(如DALL·E 3)及动画风格输入。

- 开源生态:代码与验证集公开,包含挑战性镜头运动和动作的测试数据。

Uni3C在comfyUI中的实现

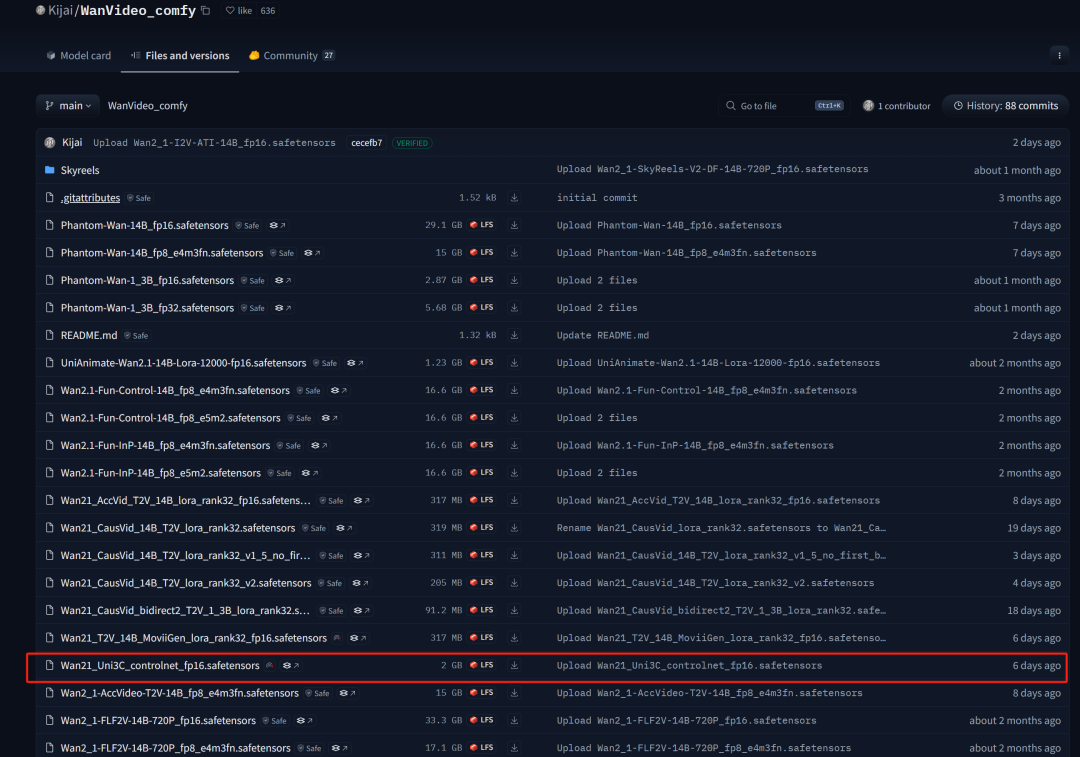

目前KJ大佬已针Uni3C模型做了量化,可以在它的抱脸页上下载这个模型:

https://hf-mirror.com/Kijai/WanVideo_comfy/tree/main

下载后放:comfyUI/models/controlnet中。同时更新KJ节点。

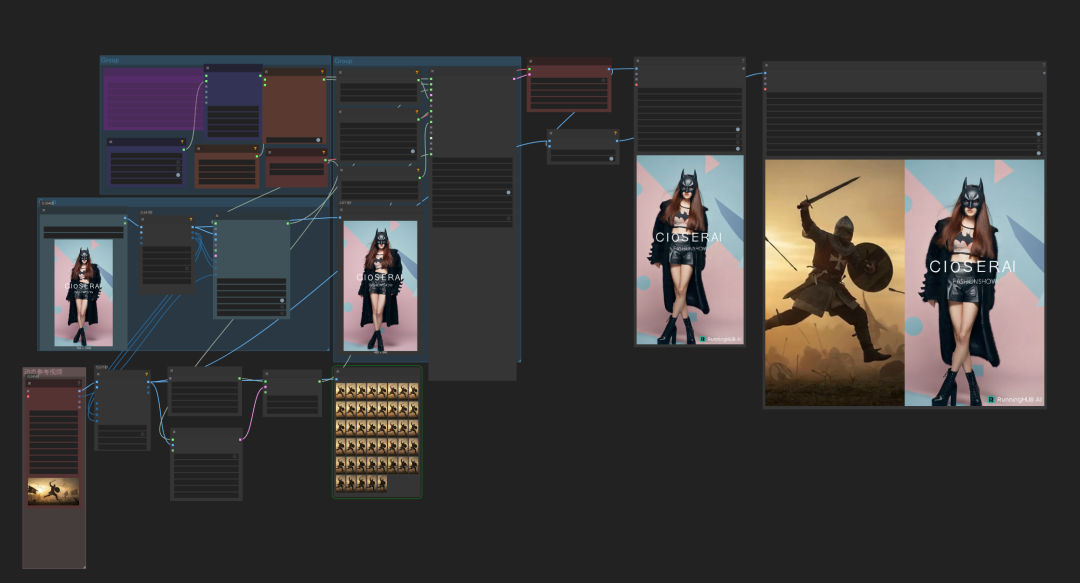

加载工作流:

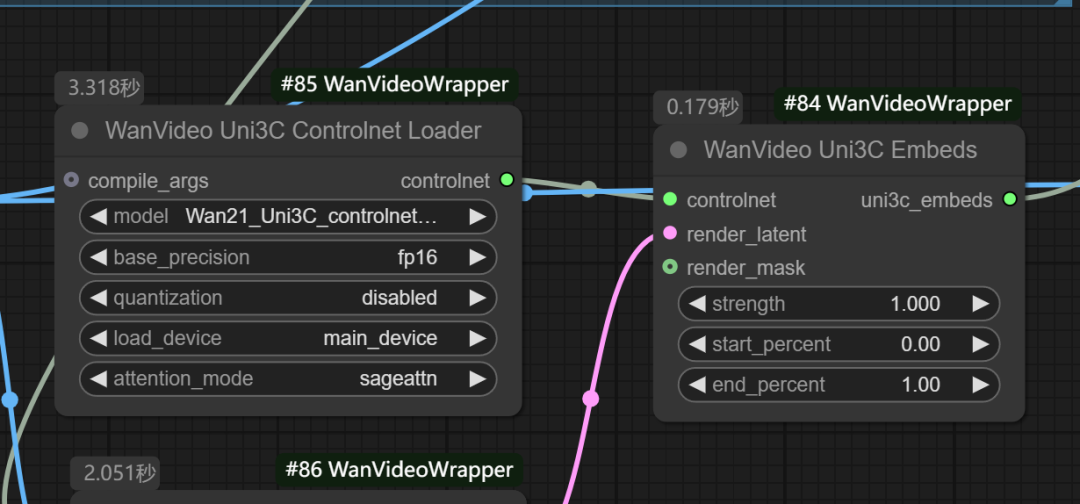

在KJ版的wan2.1工作流中增加了以下两个节点:

加载一个动态参考视频:提示词写下或者可以不写

执行生成如下:

再试一个:提示词写下:定格人物,镜头旋转

生成结果如下:

本地算力不够怎么办?

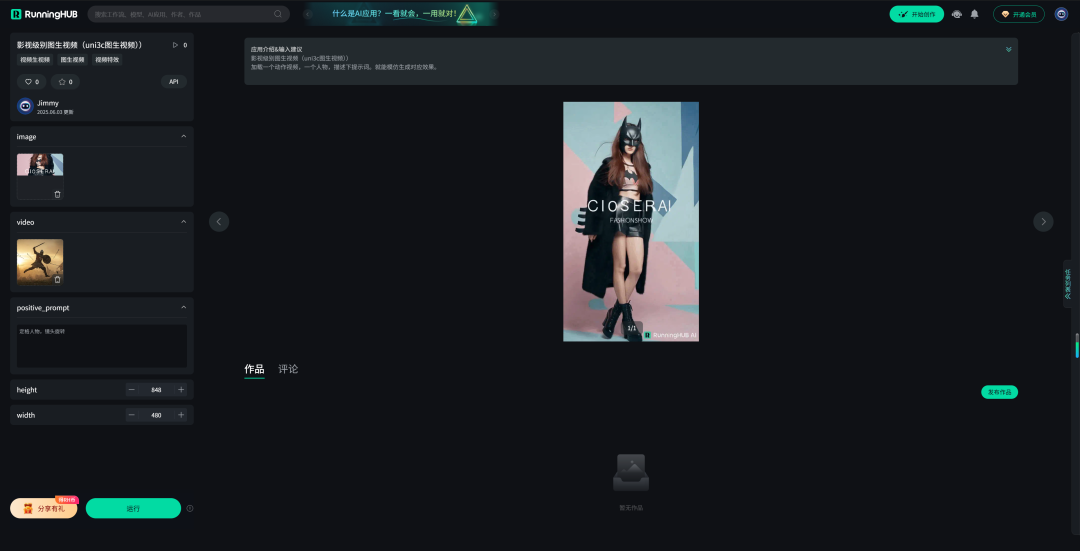

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

runninghub.cn 影视级别图生视频(uni3c图生视频)体验地址:

https://www.runninghub.cn/ai-detail/1929765374164897794

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

一个controlnet模型,就能实现电影级别的特效和人物控制,不用下载这么多其它LORA了,一个就够。让你高效出片!

以上Uni3C项目的介绍、安装与体验,以及closerAI团队制作的stable diffusion comfyUI closerAI开发的closerAI uni3c图生视频介绍,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)