更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

【closerAI ComfyUI】10步产出高质量视频!基于wan2.1的混合模型Master Model:时间与质量并存!冲!

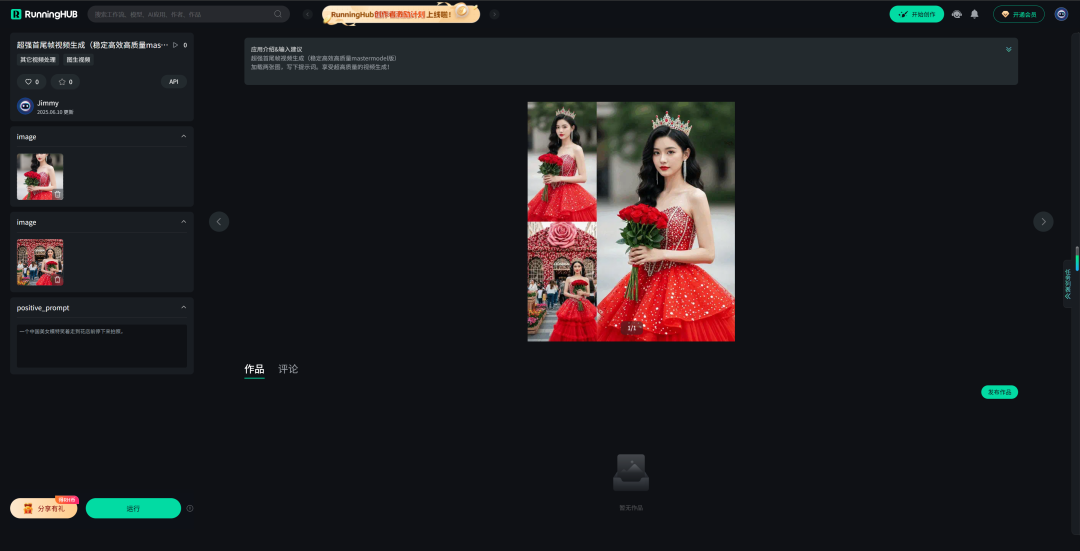

大家好,我是Jimmy。10步采样就能产出高质量视频,与VACE模型结合使用实现精准文本控制视频生成!先看效果:

上面视频,使用wan2.1的衍生模型Master Model+VACE来实现首尾帧的效果。以上左边是首图和尾图,右边是模特走秀的视频生成效果。

怎么做呢?我们先介绍今天的主角:Master Model。

Master Model介绍

基于原始WAN 2.1 T2V模型的强大合并文本到视频模型,使用多个开源组件和LoRA进行增强,以提高运动真实感,时间一致性和表现细节。多个开源模型和LoRA,以提高时间质量,表现力和运动真实感。

混合模型包括:ACCVIDEO、MoviiGen1.1、CausVid、LMPsRewards LoRA,专门为此合并创建的自定义细节增强LoRA。

其中ACCVIDEO:

【closerAI ComfyUI】速度与质量并在!万相又一加速器AccVideo:加速视频扩散模型,赋能万相全生态视频生成!爽

Moviigen1.1:

【closerAI ComfyUI】强悍!MoviiGen 1.1:电影级别的视频生成模型!电影美学与视觉质量并存的创作神器!掂

CausVid:

【closerAI ComfyUI】显存救星!300多M的LORA带来10倍加速!wan2.1-VACE大统一模型的加速器!冲!

以上加速模型和质量模型我们在前面已经介绍过。

这个Master model就是混合了这几个主要模型的能力,在速度与质量上融合成一个新模型。只需要8-10个步骤就可以获得很好的效果!真正的达到快且优的目的。

以下是它官方的示例::

它的使用方法也很简单:

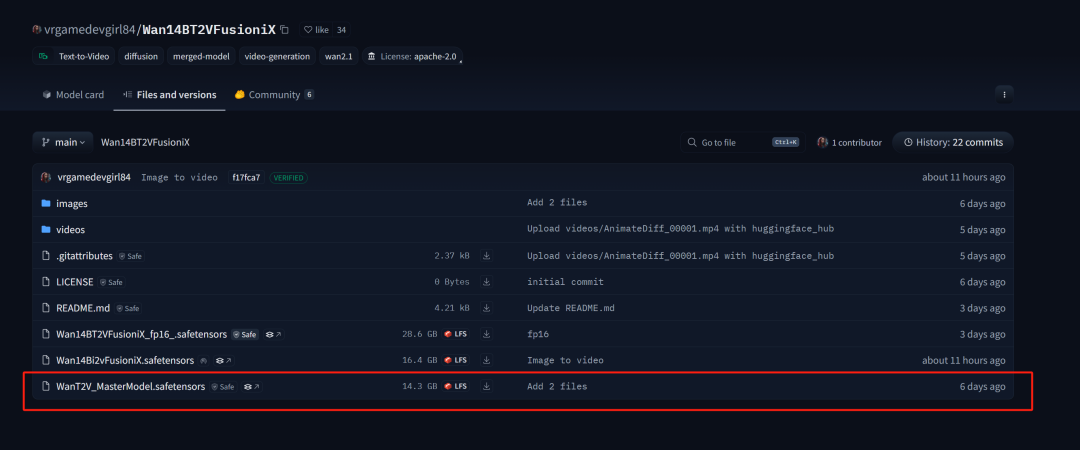

项目链接:https://hf-mirror.com/vrgamedevgirl84/Wan14BT2VFusioniX

模型下载页:

https://hf-mirror.com/vrgamedevgirl84/Wan14BT2VFusioniX/tree/main

下载后放置:ComfyUI/models/diffusion_models/文件夹里

更新KJ节点:https://hf-mirror.com/Kijai/WanVideo_comfy/tree/main

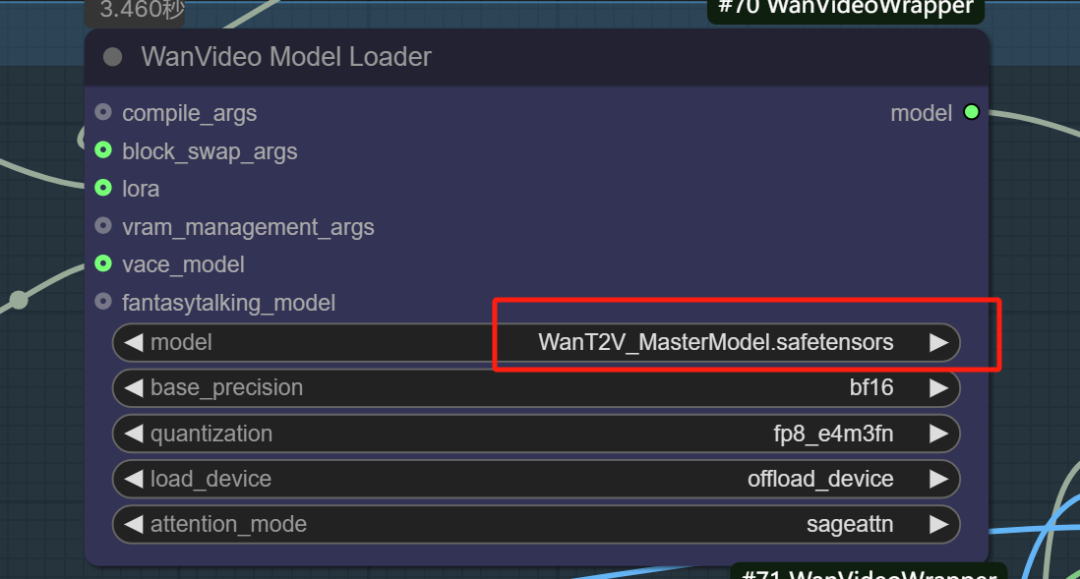

这个模型本质是文生视频,文生视频是很重要,但我们要精准控制还得是要图生视频,那怎么做呢?我们以VACE的KJ版工作流为例,加入master models进行使用。搭建了以工作流:

主要是在VACE 首尾帧工作流的基础上换成master models模型。

输入首尾图:

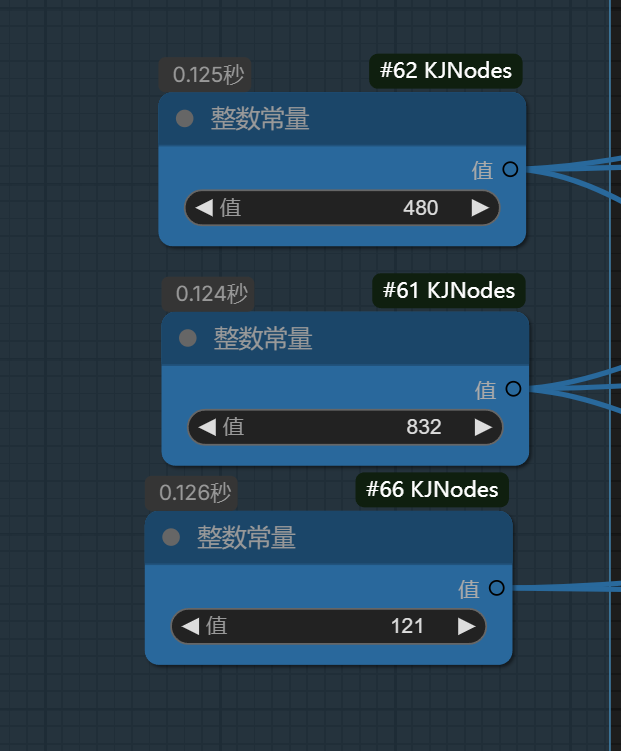

尺寸与帧率设置下:因为有加速嘛,我直接设置成121帧率。

提示词写:一个中国美女模特笑着走到花店前停下来拍照,

然后其它不变,直接执行了。

效果如下:

效果很棒,画面稳定、人物一致性保持很好,同时遵从提示词,关键在保持质量的同时还能加速。这个是121帧的!我在RH上跑了6分12秒!

本地算力不够怎么办?

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

runninghub.cn 超强首尾帧视频生成 体验地址:

https://www.runninghub.cn/ai-detail/1932269081527746561

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

8~10步就能产出稳定、快速、高质量的视频!

以上是master models的介绍,以及closerAI团队制作的stable diffusion comfyUI closerAI搭建的closerAI master models+VACE视频生成工作流介绍,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)