更多AI前沿科技资讯,请关注我们:

【closerAI ComfyUI】目前最好用!精准高效版kontext多图融合!自由组合节点+标注助手+自动白边处理+NAG+贴图LORA!完美迁移融合万物!冲!

大家好,我是Jimmy。前期分享了关于kontext多图融合最优解:

【closerAI ComfyUI】这就是kontext多图融合最优答案!结合Kontext多图融合的思考!找出最优融合方案!

通过结合NAG,NAG 全称是 Normalized Attention Guidance(归一化注意力引导),是一种用于扩散模型(Diffusion Models)的通用负向引导技术,让kontext多图融合更精准。

围绕这个思路,下面就打磨效率和质量方面的优化。在这次的kontext多图融合工作流中,我做了几个优化,减少我们介入,提高效率:

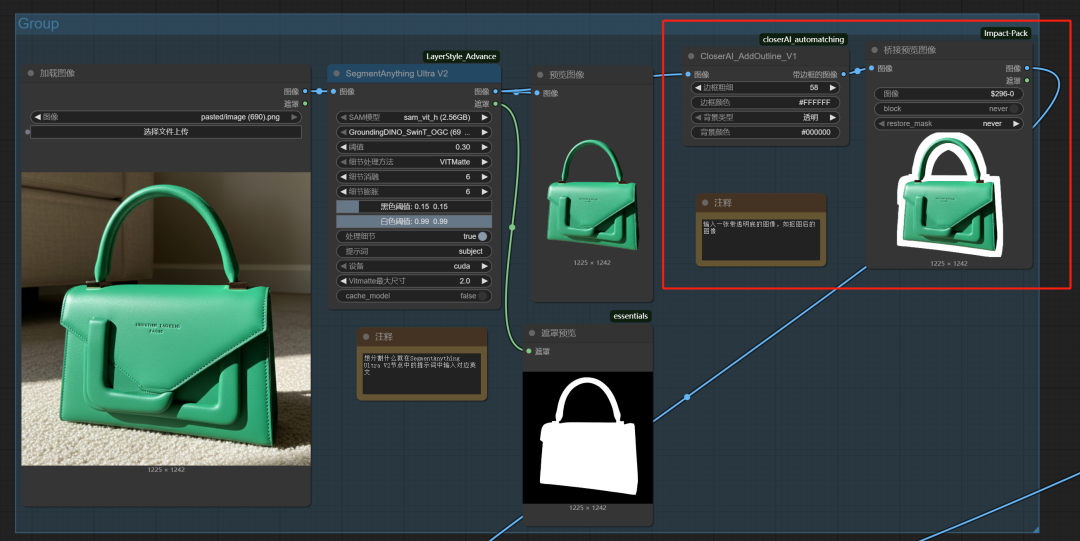

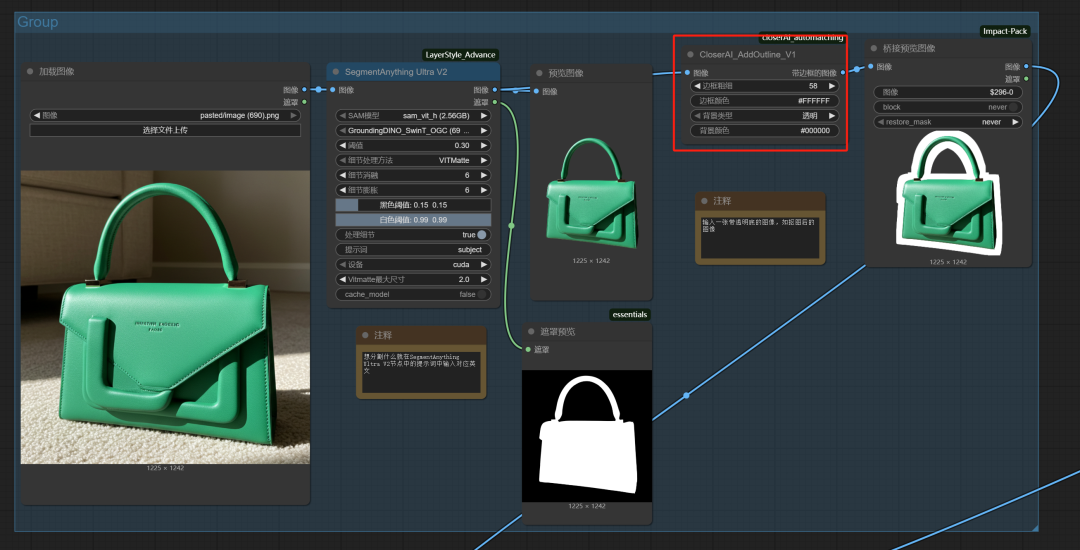

1、开发了一个自动白边处理的节点,直接将带有透明底的抠图接入后,生成围绕物体轮廓的白边。还能控制粗细。

这里解决的是,使用万能贴图LORA时,有时候不能出效果的问题,加上白边,更容易出图。但是手动涂抹实在麻烦。所以索性开发了一个节点,直接自动处理。

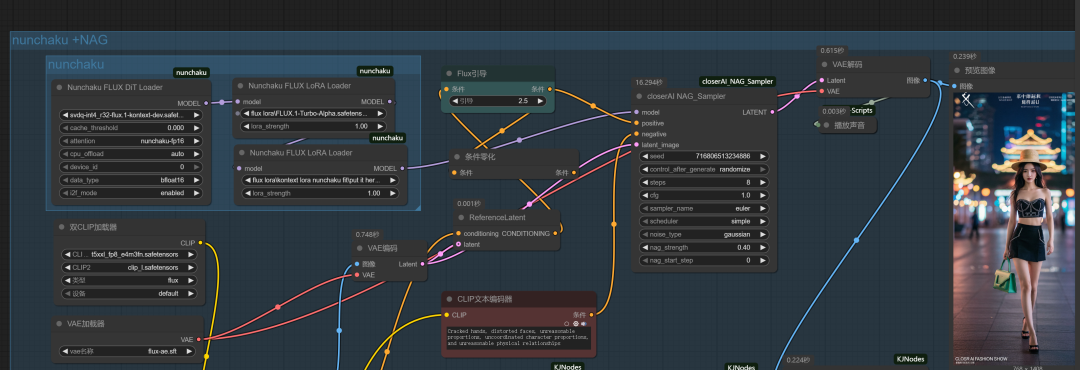

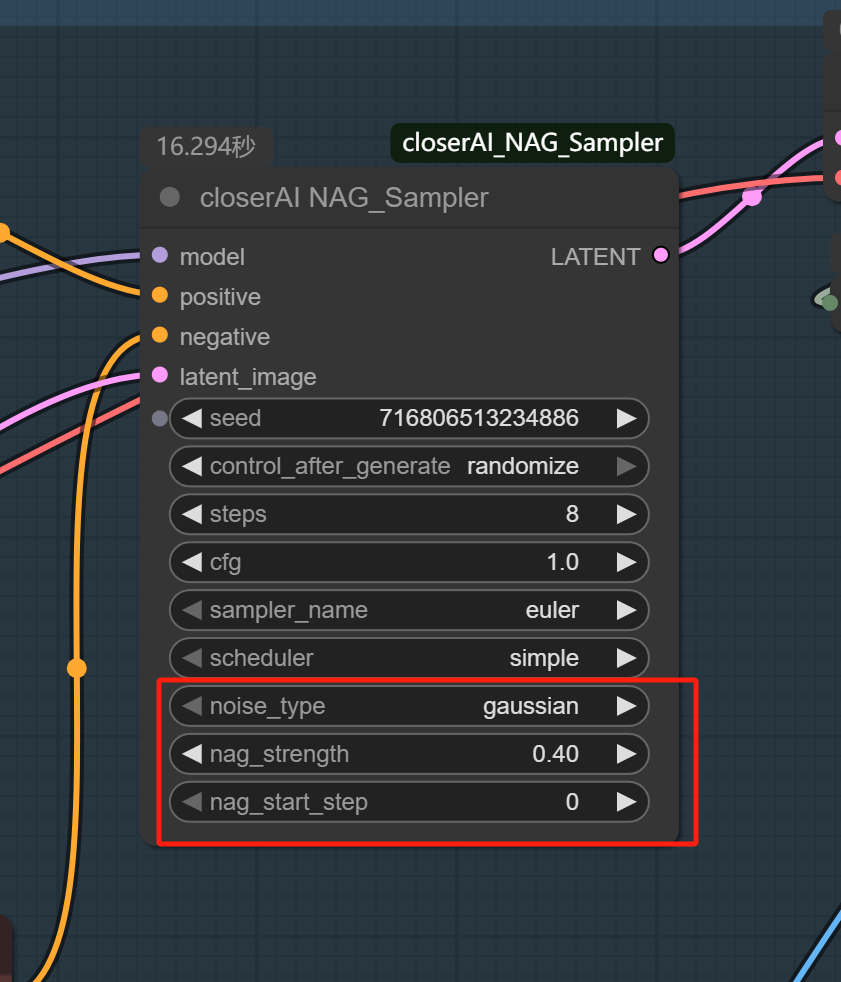

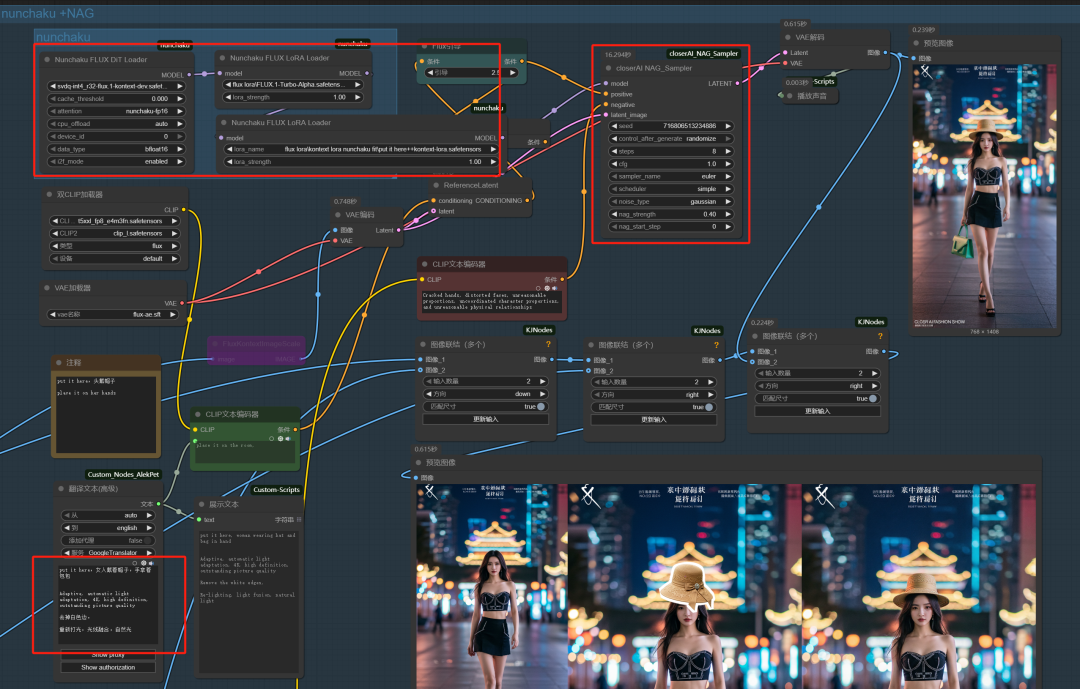

2、开了closer NAG 采样器节点,支持nunchaku版本。

上期我们介绍NAG加持下更精准生成高质量的结果:

【closerAI ComfyUI】这就是kontext多图融合最优答案!结合Kontext多图融合的思考!找出最优融合方案!

但是那期的工作流,我接入了unet或者是GGUF的kontext版本模型。不是说不行。但我比较喜欢nunchaku的高效!,但comfyUI-NAG目前没能支持nunchaku。所以索性,我研究了下重新开发一个节点支持让nunchaku支持NAG。如下图示:

本节点的使用方式与 ComfyUI 内置的 KSampler 基本一致。

- model: 核心输入。连接您的模型加载器。

- 如果使用 LoRA: 请连接 Nunchaku LoRA Loader 链条最后一个节点的 MODEL 输出。

- 如果不使用 LoRA: 直接连接主模型加载器(如 FLUX.1-dev Loader)的 MODEL 输出。

- positive: 连接“正面提示词”编码节点的 CONDITIONING 输出。

- negative: 连接“负面提示词”编码节点的 CONDITIONING 输出。

- latent_image: 连接 Empty Latent Image (文生图) 或 VAE Encode (图生图) 的 LATENT 输出。

- LATENT (输出): 将此接口连接到 VAE Decode 节点,以生成最终图像。

NAG 专属参数,这是控制 NAG 效果的核心。

- noise_type: 引导噪声的类型。

- gaussian (高斯噪声): 最常用,效果最稳定。推荐使用。

- uniform (均匀噪声): 提供一种不同的噪声分布,可用于实验。

- nag_strength (NAG 强度): 最重要的参数。

- 它控制着每一步被注入的额外噪声的强度。

- 0.0 表示完全禁用 NAG,此时节点等同于一个标准 KSampler。

- 推荐范围: 0.1 ~ 0.5。建议从 0.2 开始尝试。

- 注意: 过高的值 (如 > 1.0) 可能会在图像中引入不自然的噪点或伪影。

- nag_start_step (NAG 起始步数):

- 控制从第几步开始应用 NAG。

- 0 (默认): 从第一步采样就开始应用 NAG。

- 高级用法: 您可以设置一个较高的值,让 NAG 只在采样的后半段介入,用于对已经基本成型的图像进行细节微调。例如,如果总步数是 20,您可以将此值设为 10。

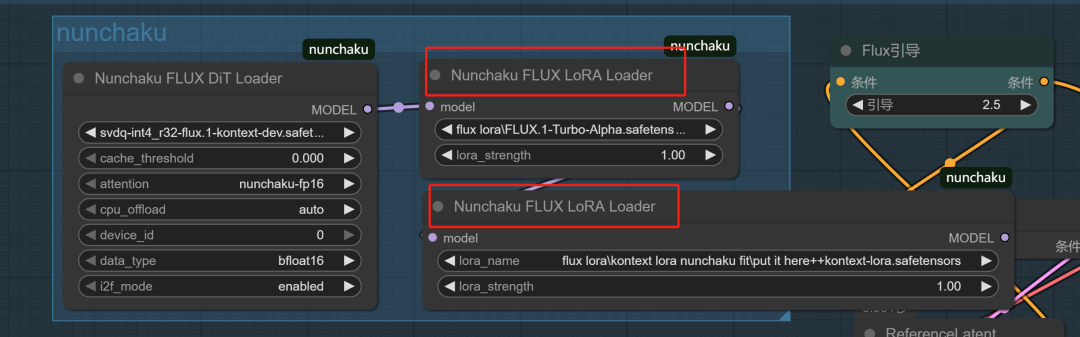

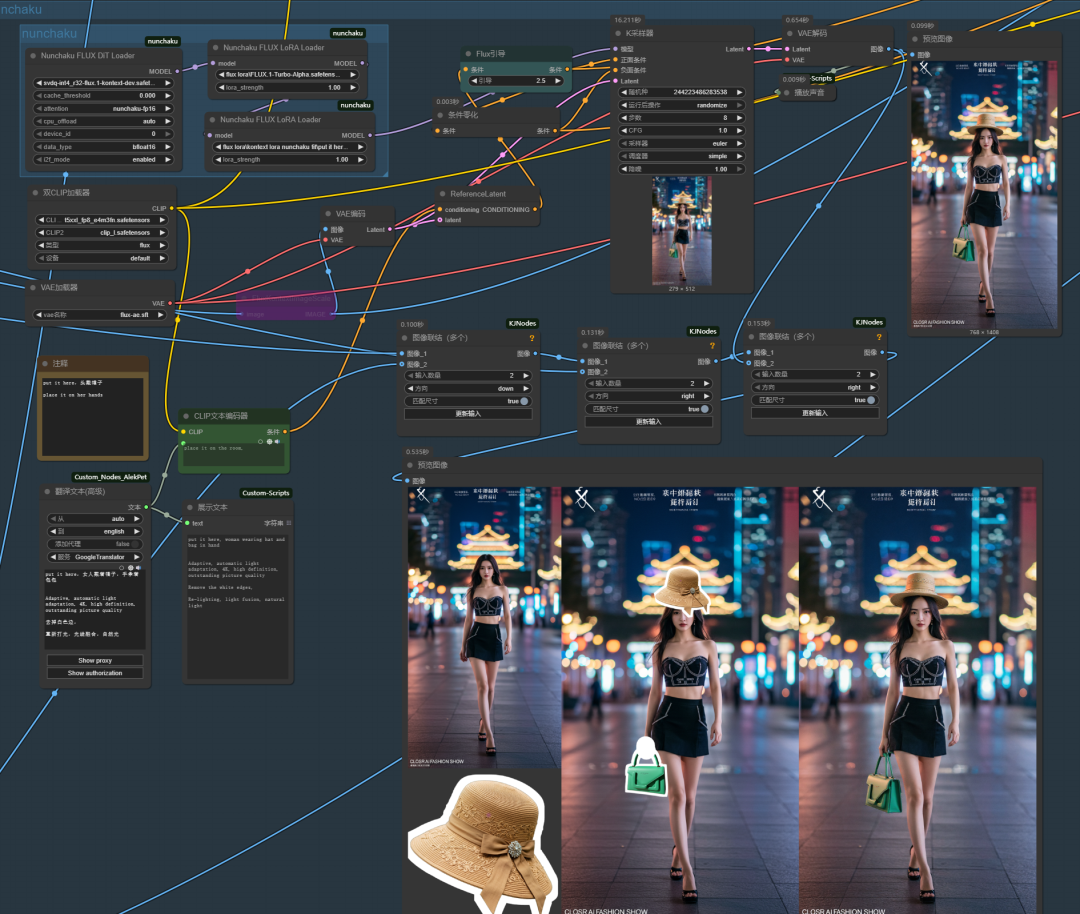

3、nunchaku kontext lora的问题。

这里使用了技术来源:小破站 张的张的 大佬做的修复文件。现在能愉快地将LORA转化成支持nunchaku的了。

这里讲下它接入LORA方式,在我们转换成nunchaku版本的lora后,一定要使用nunchaku官方的lora加载器来加载lora。这样才有效。

接法如截图示。

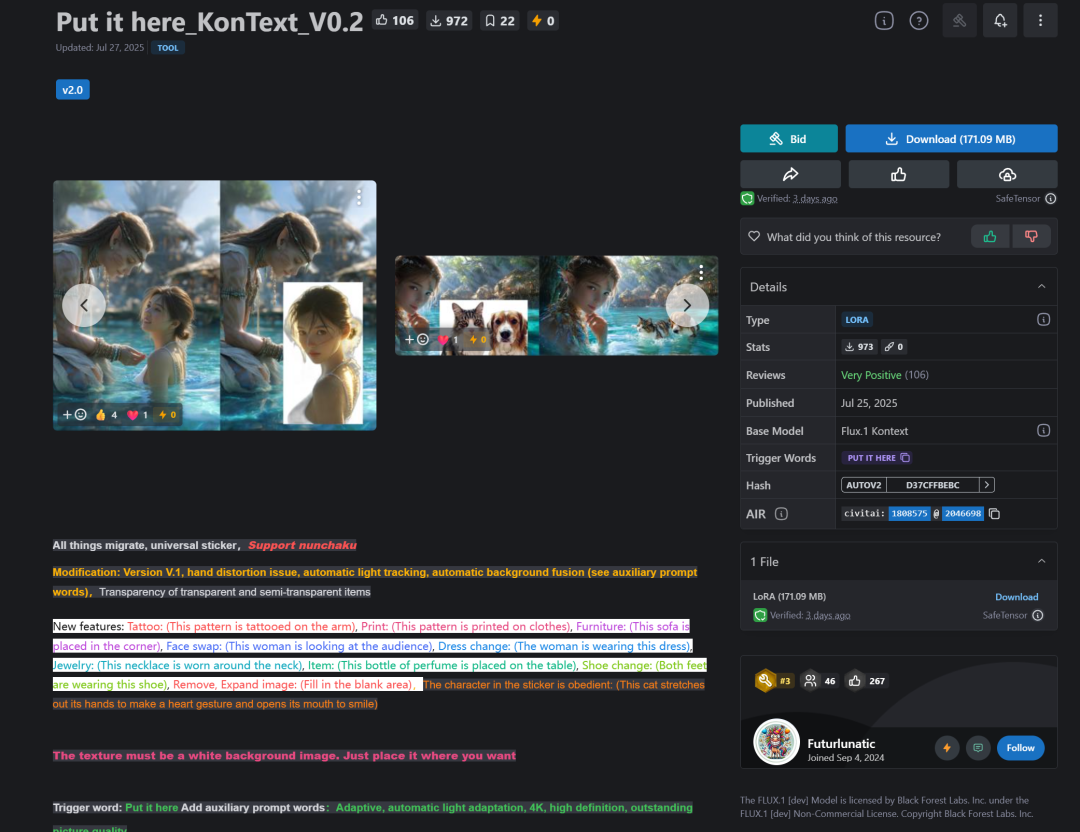

4、put it here lora更新到V2.0版本了

触发词:Put it here

辅助提示词:Adaptive, automatic light adaptation, 4K, high definition, outstanding picture quality

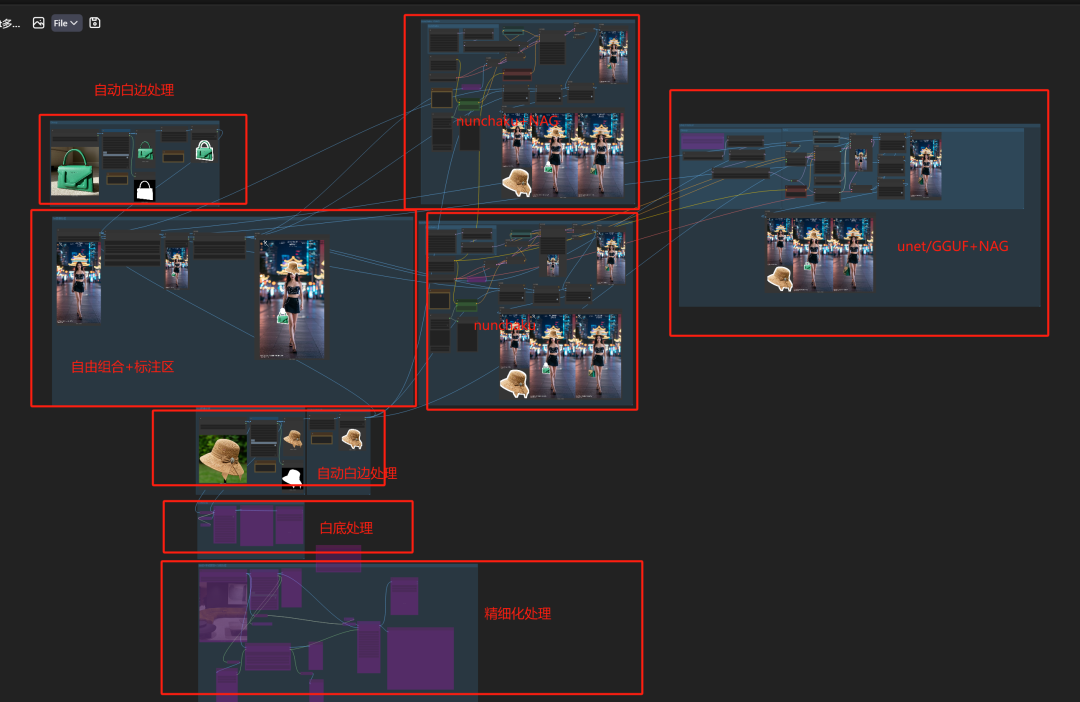

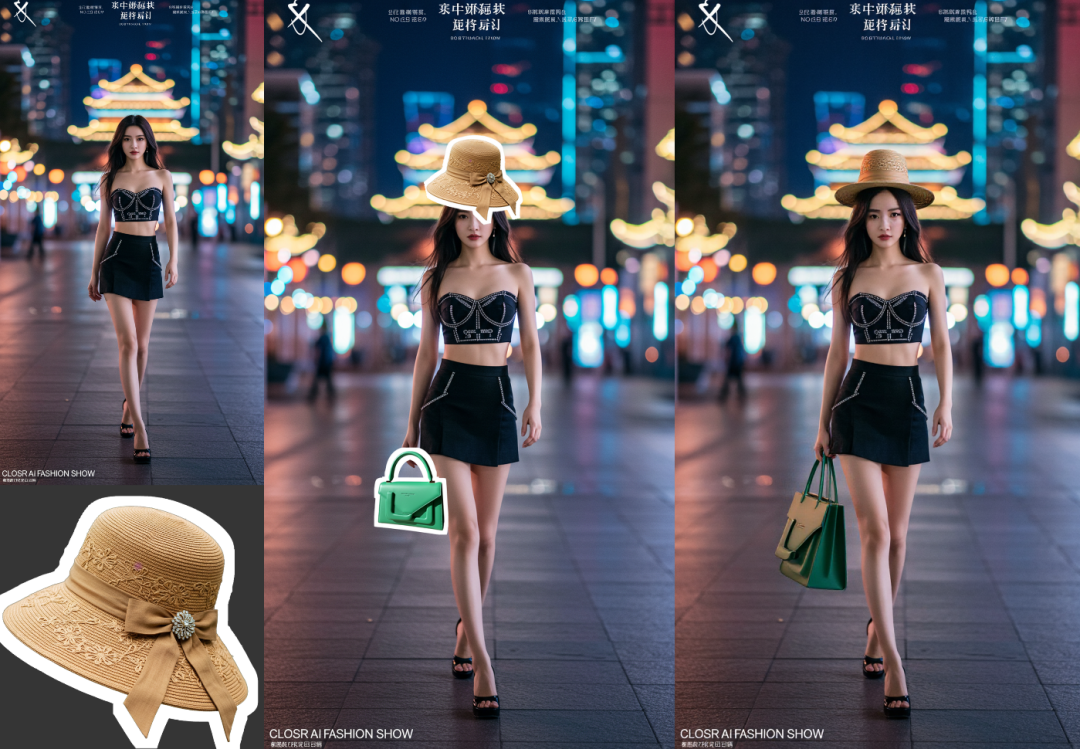

至此优化后的,closerAI kontext多图融合工作流如下:

1、自动处理白边模块:使用万能分割,将抠图直接接入我开发的CloserAI_AddOutline_V1节点中,白边粗细自己根据情况调整。

如果要接入N个物体,就复制多个这样的模块出来。

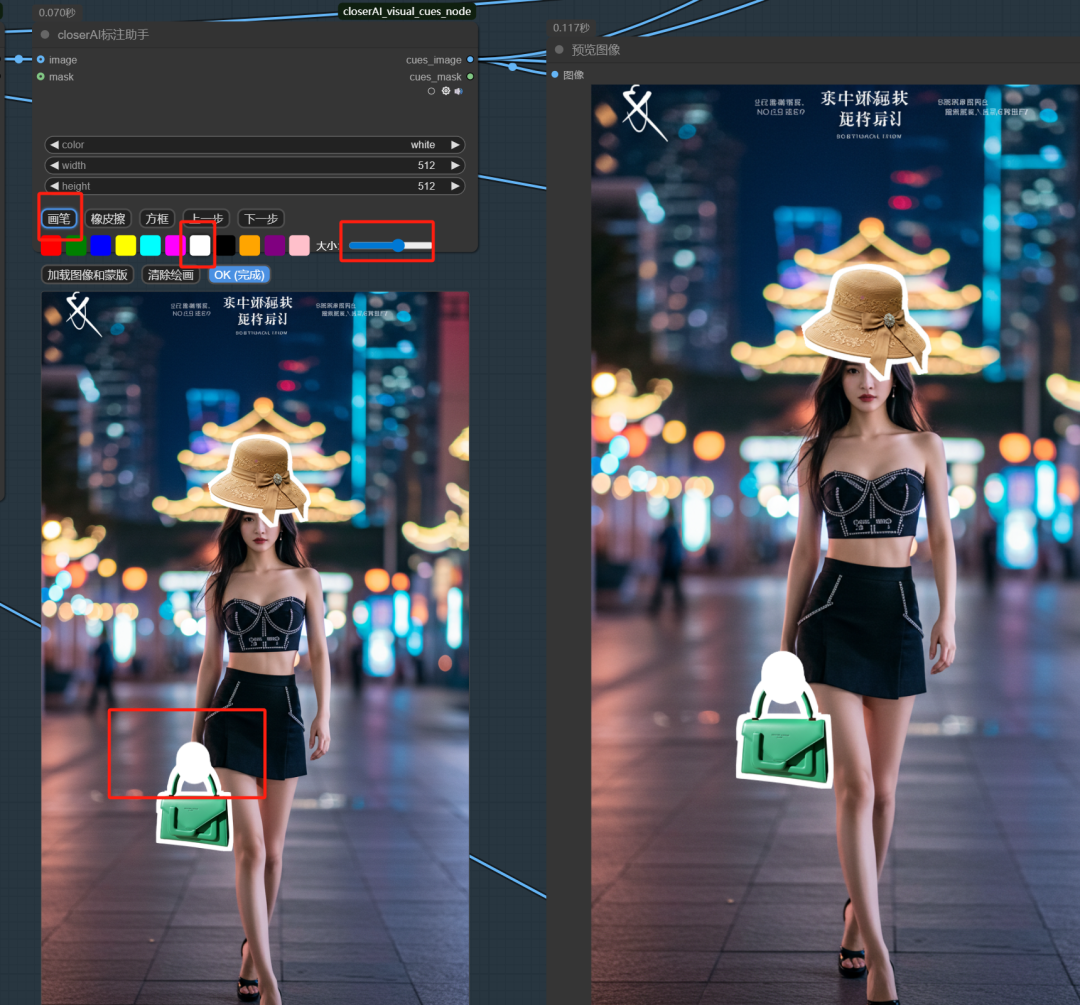

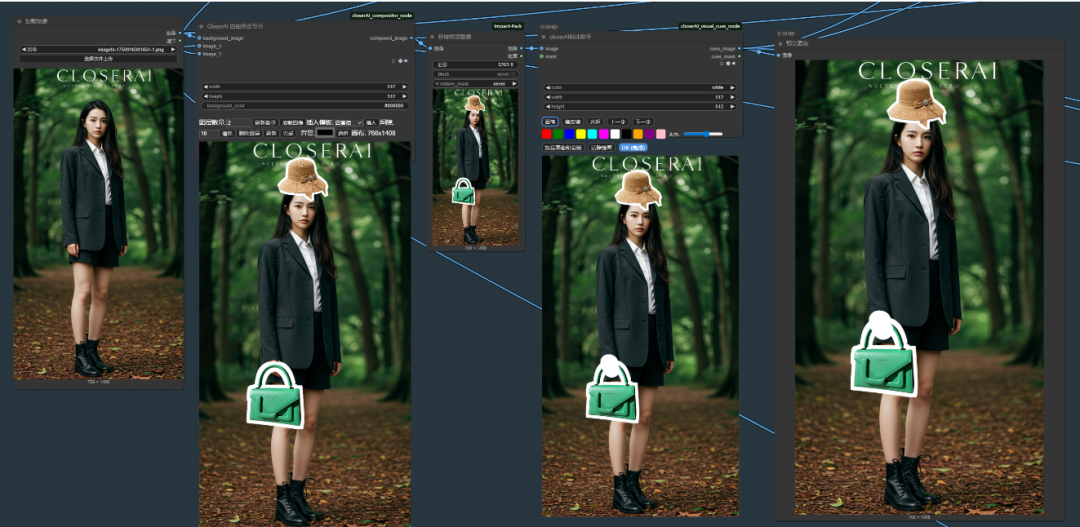

2、closerAI自由组合节点+标注助手:组合图片

如果需要多张图进行组合,可以在数量上填写对应数值,点击刷新。接入源就会发生变化,然后加载图像进工作区中。调整位置,点击完成。

标注助手的接入,是为了有时候,我们需要它做一些变化的区域,像手拿,但是白色没遮挡住,这个时候可以手动补上去,如下图:

也有时候就算不使用白边,使用的直接是白底的,你也遮挡不住一部分,如上一期的:

矩形区域是白底图,但我需要人物拿着伞,所以,这里在椭圆位置我直接用标注助手手画一个区域。

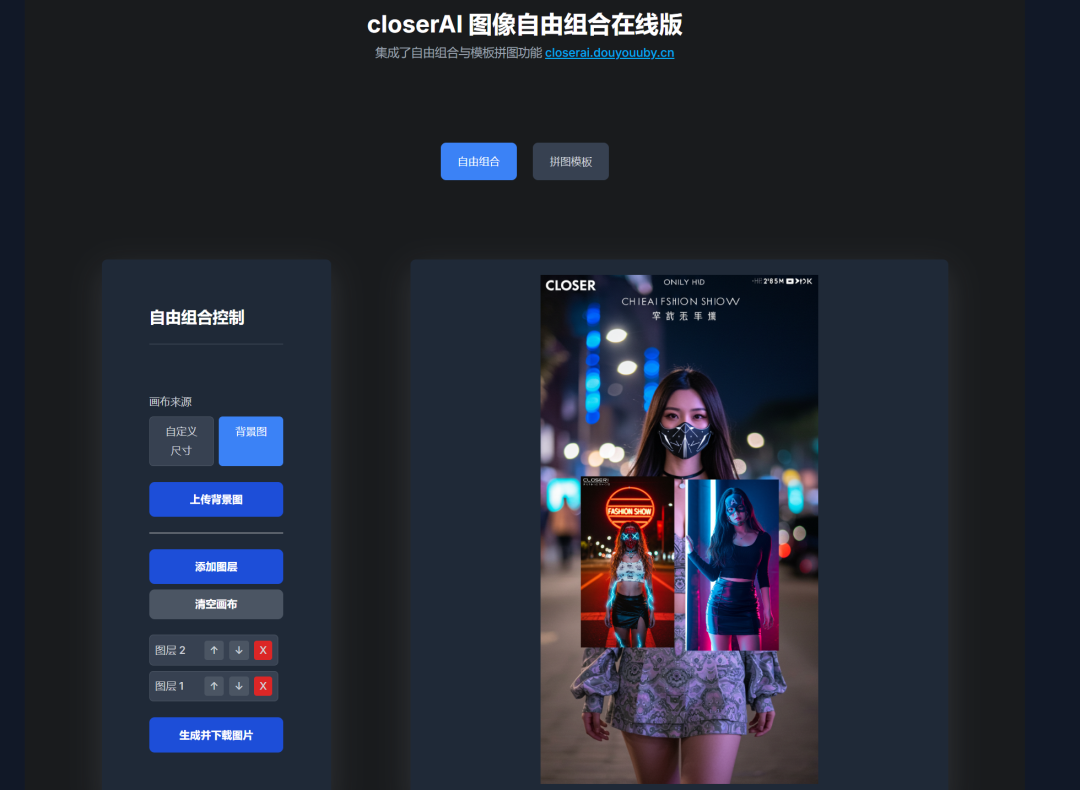

当然,如果大家没有我们的closerAI节点,我为大家准备了网页版本的自由组合的应用:

closerAI 图像自由组合在线版

大家可以在上面使用。

3、主要工作流模块:

1)nunchaku+NAG的kontext单图编辑工作流程如下:

它执行的结果如理:

2)nunchaku的kontext单图编辑工作流程如下:

执行后结果:

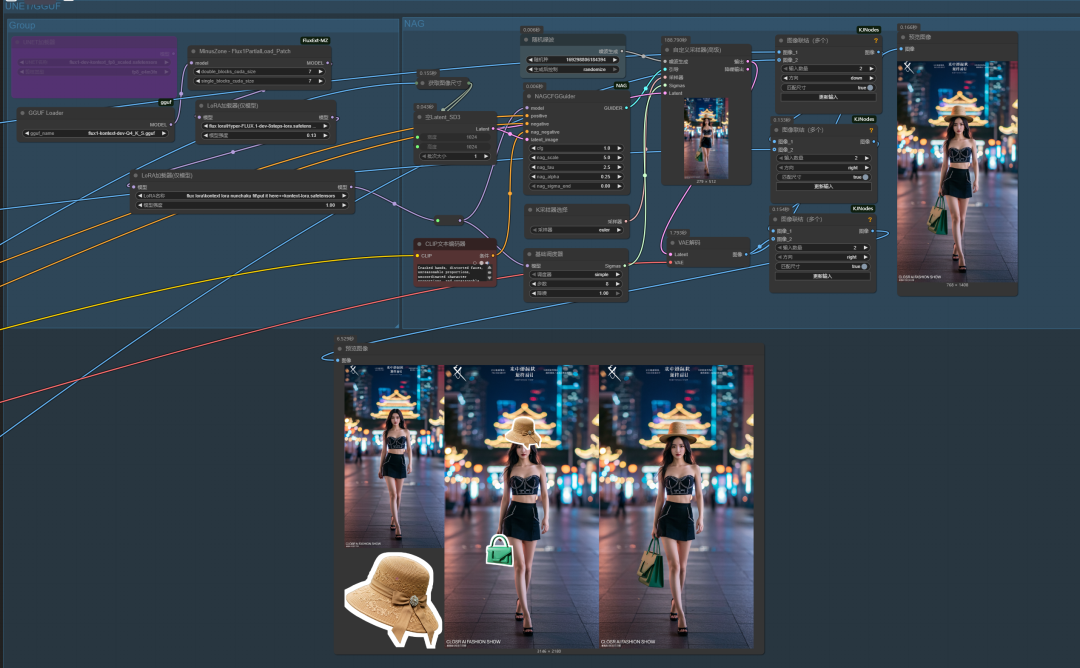

3)unet/gguf加载kontext对应量化模型的kontext+NAG的单图编辑工作流程如下:

执行结果:

我们再尝试换一张图看看:

换张图,重新组合如下:

执行结果:

1)nunchaku+NAG的kontext单图编辑工作流结果:

2)nunchaku的kontext单图编辑工作流结果:

3)unet/gguf+NAG的kontext单图编辑工作流结果:

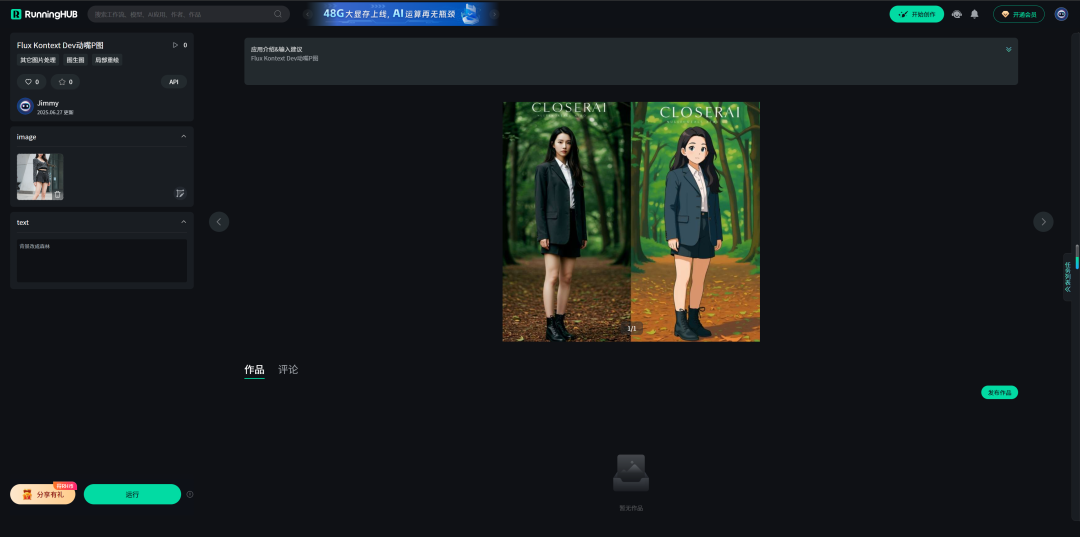

本地算力不够怎么办?

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

Flux Kontext Dev动嘴P图流体验地址:

https://www.runninghub.cn/ai-detail/1938445554957639681

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

以上思路跟大家分享,目前是我优化后的kontext多图融合最高效的方案,

质量好设备好,建议直接使用unet加载FP8 kontext dev版本。但要追求效率与质量并在的,就可以直接使用nunchaku+NAG的版本。

以下是我开发的节点,配合kontext能高效出片:

1、comfyUI kontext 标注助手节点:

http://closerai.douyoubuy.cn/2025/07/01/2089/

2、comfyUI kontext提示词生成器节点:

http://aigc.douyoubuy.cn/2025/06/30/2062/

3、closerAI 图像循环助手节点:

http://aigc.douyoubuy.cn/2025/07/05/2137/

4、closerAI 自由组合节点:

http://aigc.douyoubuy.cn/2025/07/24/2305/

5、closerAI 自动白边处理节点:

http://aigc.douyoubuy.cn/2025/07/28/2357/

6、closerAI NAG_Sampler节点:

http://aigc.douyoubuy.cn/2025/07/28/2354/

7、comfyUI kontext提示词生成器网页应用:

http://aigc.douyoubuy.cn/closerai-flux-kontext/

8、closerAI 图像自由组合在线版

http://aigc.douyoubuy.cn/closerai-imagefree/

以上是closerAI团队制作的stable diffusion comfyUI closerAI开发的节点以及closerAI kontext多图融合自动白边处理+贴图LORA+NAG 工作流介绍,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)