更多AI前沿科技资讯,请关注我们:

【closerAI ComfyUI】王炸尝鲜玩:nunchaku z-image将要来临!最强国产开源文生图模型的高光前兆!冲!

大家好,我是Jimmy。

今年最强开源文生图模型z-image-turbo在11月底高光过:【closerAI ComfyUI】真实!美学!开放!开源图像模型巅峰战?代号Z文生图模型锋芒盖过FLUX2!一站成名之作!6!一出甚至扼杀Flux2在摇篮中。随之就是一系列的LORA、Controlnet支持。它的能力,毋庸置疑,它的质量,美感都是开源排行榜前几。关键,关键还是NSFW随便玩。

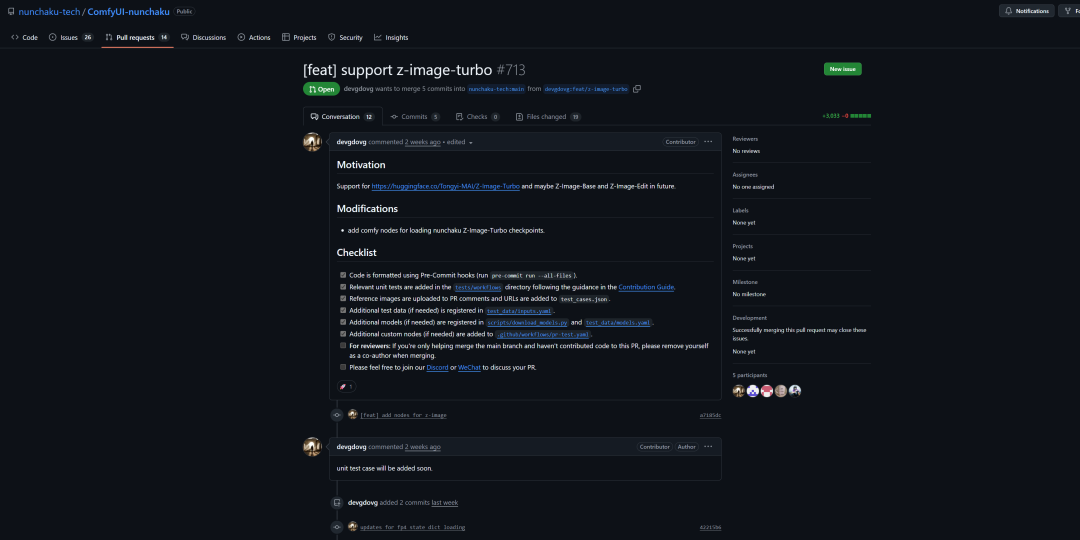

这几天,在nunchaku仓库中有大佬已提交了合并代码,现在还未正式发布,但是,代码已提交,其分支也有代码。

所以,在nunchaku未发布前,我先体验下了。今天捣鼓了一下,坑有点多。但好在,跑通了。

nunchaku,不用多说了吧?快就一个字。下面我将分享下这个安装与体验过程。

一、介绍

模型地址:https://hf-mirror.com/nunchaku-tech/nunchaku-z-image-turbo

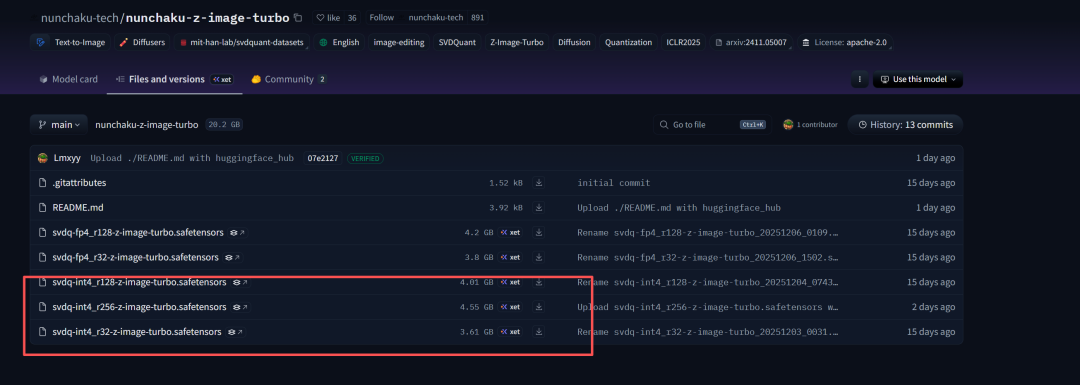

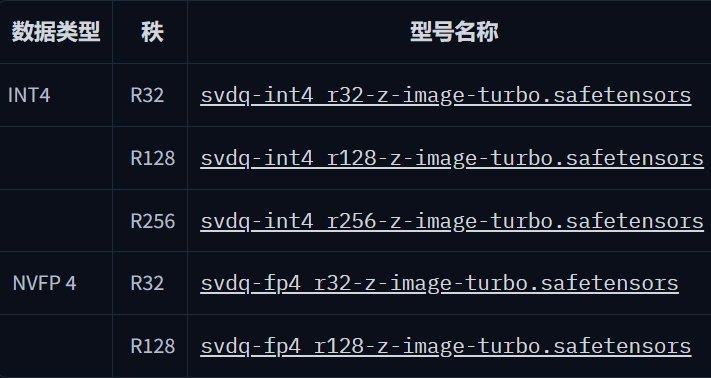

数据类型:INT4用于非Blackwell GPU(50系列之前),NVFP4用于Blackwell GPU(50系列)。

说明:

r32为了更快的推理,

r128为了获得更好的质量但更慢的推理,

r256用于最高质量(最慢的推断)。

下载对应模型,我这里下载折中一点的svdq-int4_r128-z-image-turbo.safetensors,并将模型放置到models/diffusion models中。

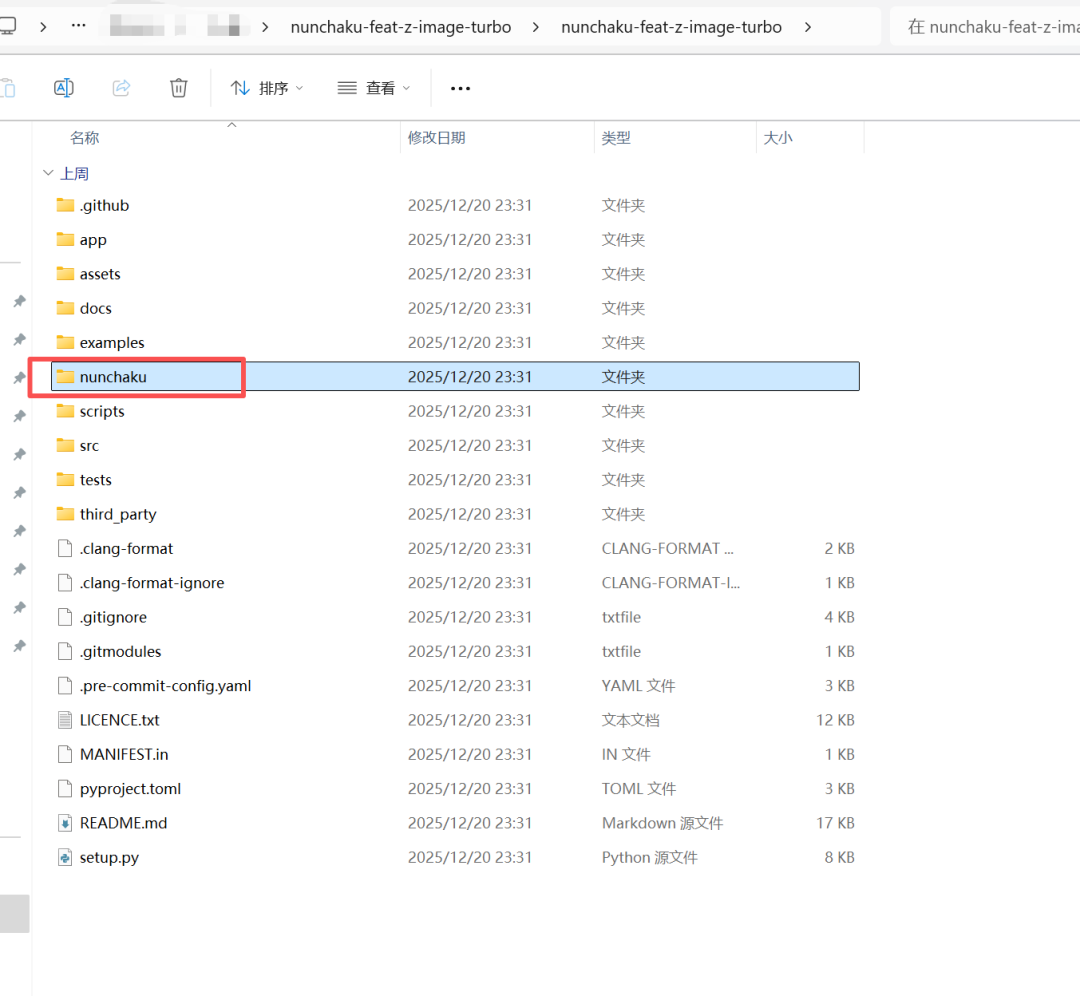

二、节点代码

首先是这个大佬在nucnahku仓库上提交的代码:https://github.com/nunchaku-tech/ComfyUI-nunchaku/pull/713/commits/44b2d43216e28f502a82e4e575d190e8c7adb056

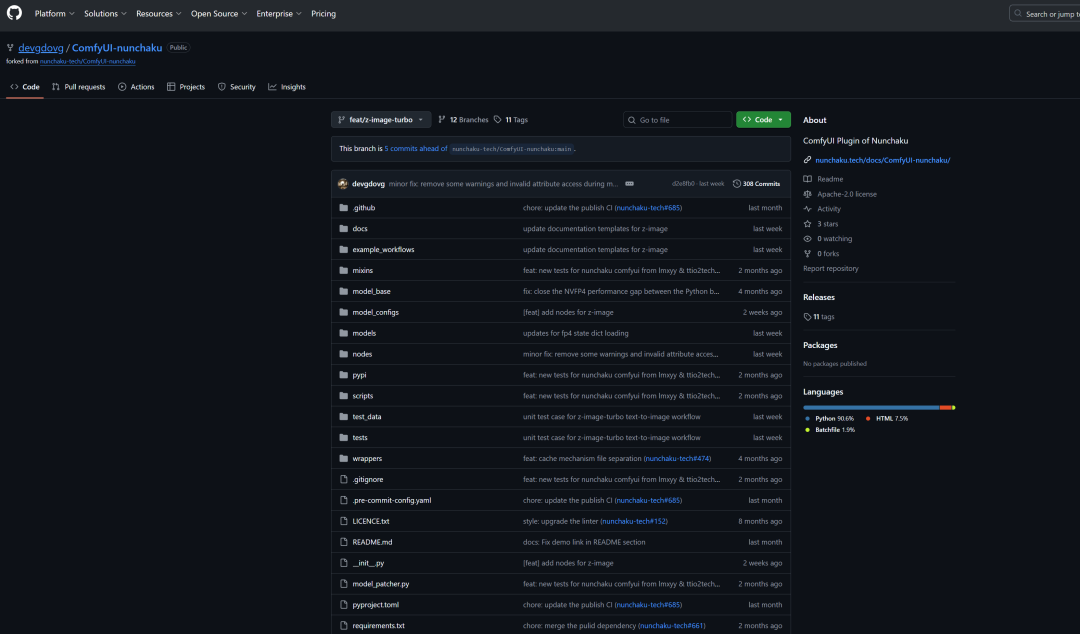

从这里,我顺藤摸瓜,找到分支地址:https://github.com/devgdovg/ComfyUI-nunchaku/tree/feat/z-image-turbo

下面是我的一些具体安装操作

第一步:安装 ComfyUI 插件

- 下载插件代码:

- 仓库:devgdovg/ComfyUI-nunchaku

- 分支:feat/z-image-turbo

- 下载它的分支压缩包。(会员小伙伴直接在第一步下载这个节点安装即可)

解压后,将文件夹重命名为 ComfyUI-nunchaku。

放入 ComfyUI/custom_nodes/ 目录下。

- 最终路径应为:.../custom_nodes/ComfyUI-nunchaku/、

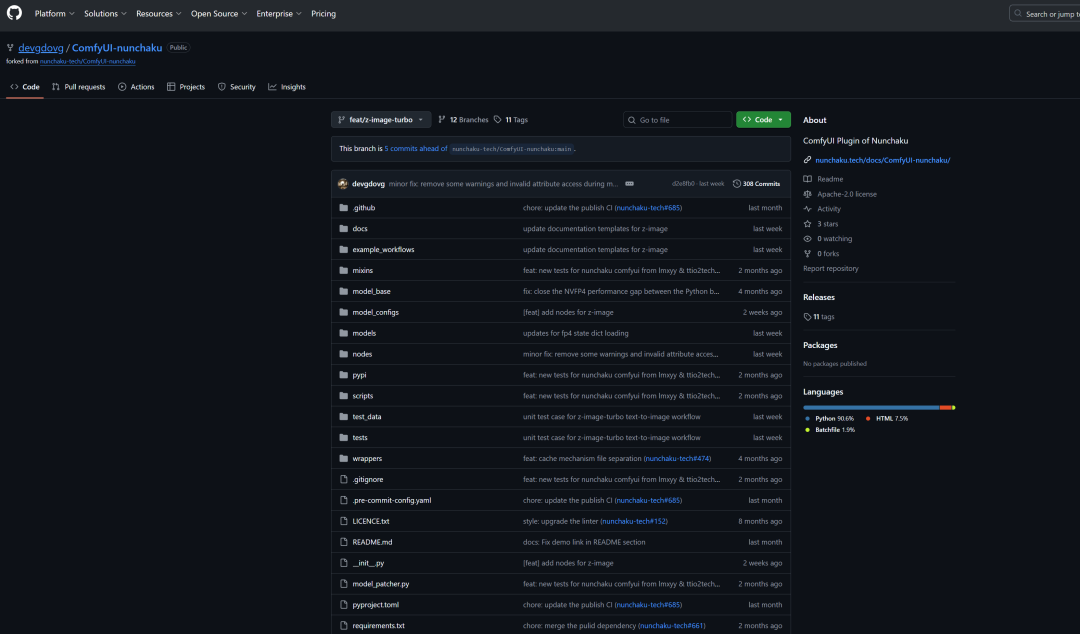

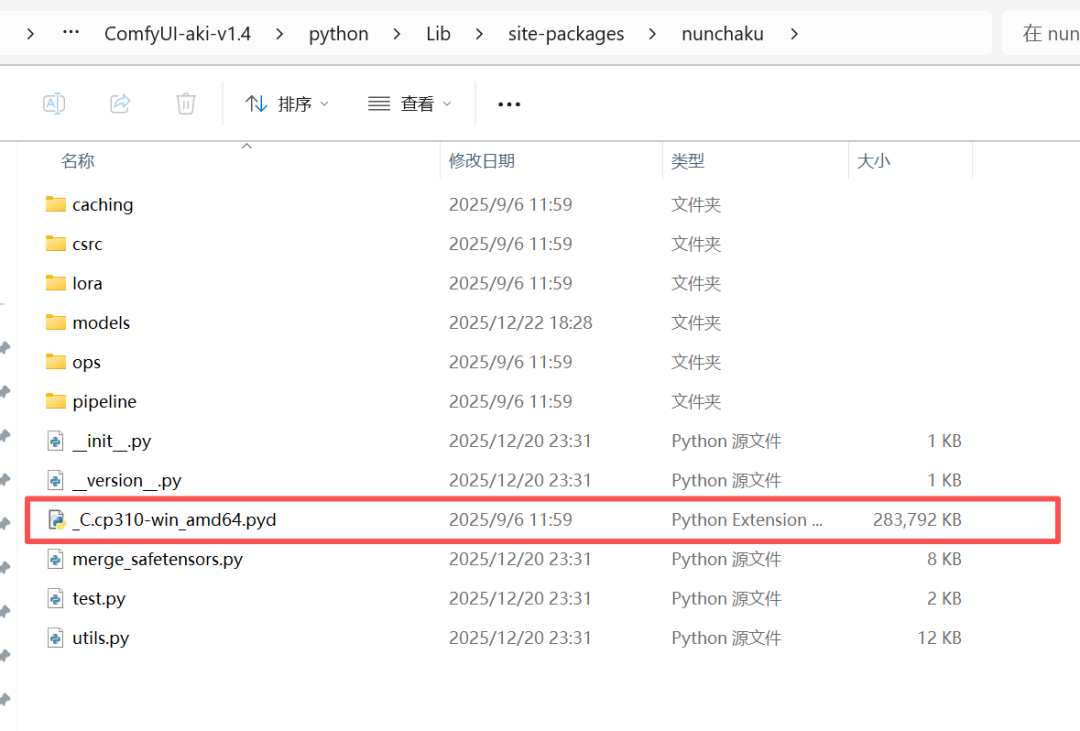

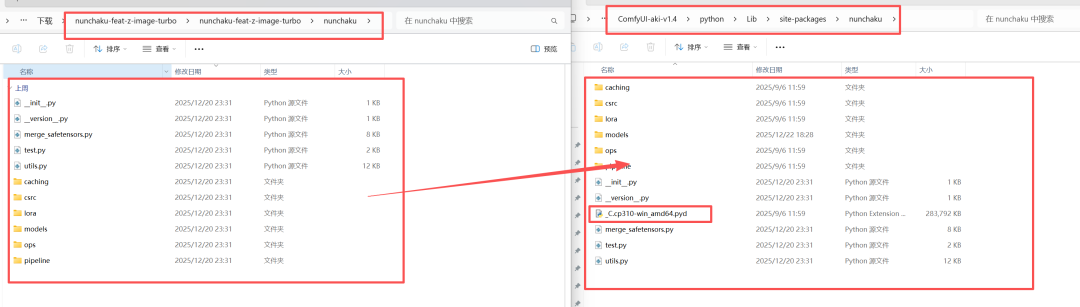

第二步:安装 Nunchaku 核心库 (Backend - 移花接木法)

这是最关键的一步,我们需要官方的编译文件(.pyd)加上开发版的 Python 代码。

- 安装官方版(为了获取底层加速文件): 在 ComfyUI 的 Python 环境下运行:pip install nunchaku

确保安装成功,此时 site-packages/nunchaku 里会有 _C.pyd 或类似文件。

原来有安装过的nunchaku的可以不用再操作;

2、下载开发版源码(为了获取 Z-Image 逻辑):

- 仓库:devgdovg/nunchaku

- 分支:feat/z-image-turbo

- 点击下载 ZIP:https://github.com/devgdovg/nunchaku/archive/refs/heads/feat/z-image-turbo.zip 覆盖代码:

- 解压下载的 ZIP,找到里面的 nunchaku 子文件夹(包含 models, transformers 等)。

- 打开你的 ComfyUI Python 库目录:.../python/lib/site-packages/nunchaku/。

- ⚠️动作:将解压出的新文件全选复制,粘贴到 site-packages/nunchaku 中。

- ⚠️ 重点:当提示“是否覆盖”时,选择是。绝对不要删除原文件夹,否则会丢失 _C.pyd 导致报错。

第三步:升级 Diffusers 库 (Dependencies)

Z-Image 是 Diffusers 库才加入的新功能,稳定版还没有。

- 下载 Diffusers 开发版 (Main Branch) 源码: https://github.com/huggingface/diffusers/archive/refs/heads/main.zip

- 解压,并在终端进入解压后的文件夹。

- 执行强制安装命令:

pip install . --force-reinstall --no-deps

验证:运行 python -c "from diffusers.models.transformers import transformer_z_image; print('OK')" 输出 OK 即成功。

第四步:下载专用量化模型 (Models)

- 下载地址:HuggingFace: nunchaku-tech/nunchaku-z-image-turbo

- 选择文件:这里我使用int4的模型。50系列显卡用fp4的模型。

- 推荐:svdq-int4_r256-z-image-turbo.safetensors (画质佳)

- 或者:svdq-int4_r128-z-image-turbo.safetensors (速度快)

- 放置位置:ComfyUI/models/diffusion_models/。

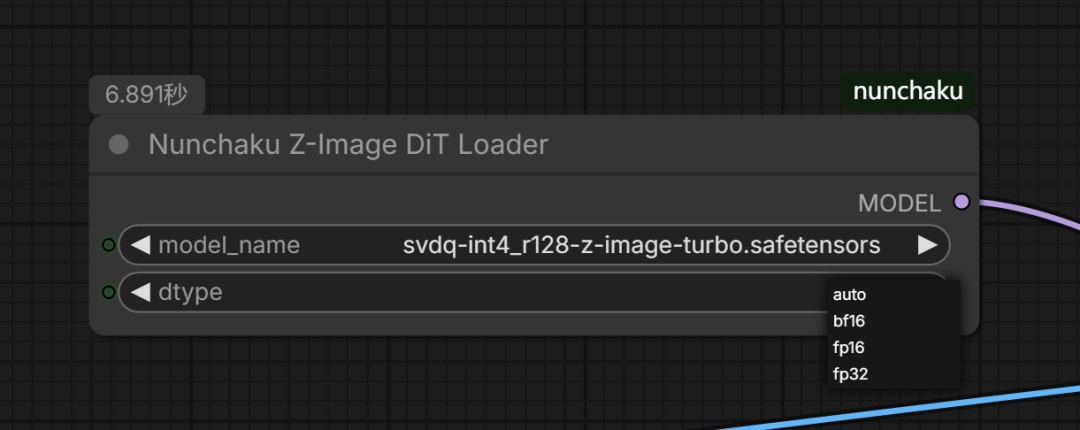

第五步,我在原来作者基础上增加了数据类型。修改了下代码。也好增加一个数据类型供选择。大家不一定有数据类型的报错。(会员小伙伴直接在第一步下载这个节点安装即可)

重启就好了。

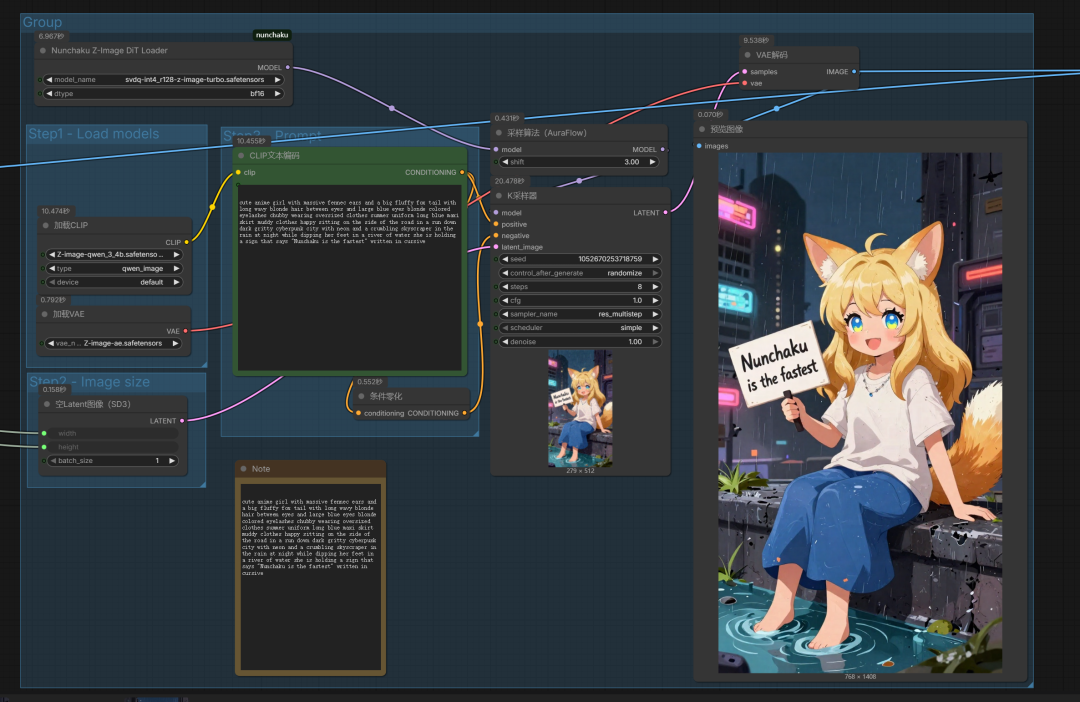

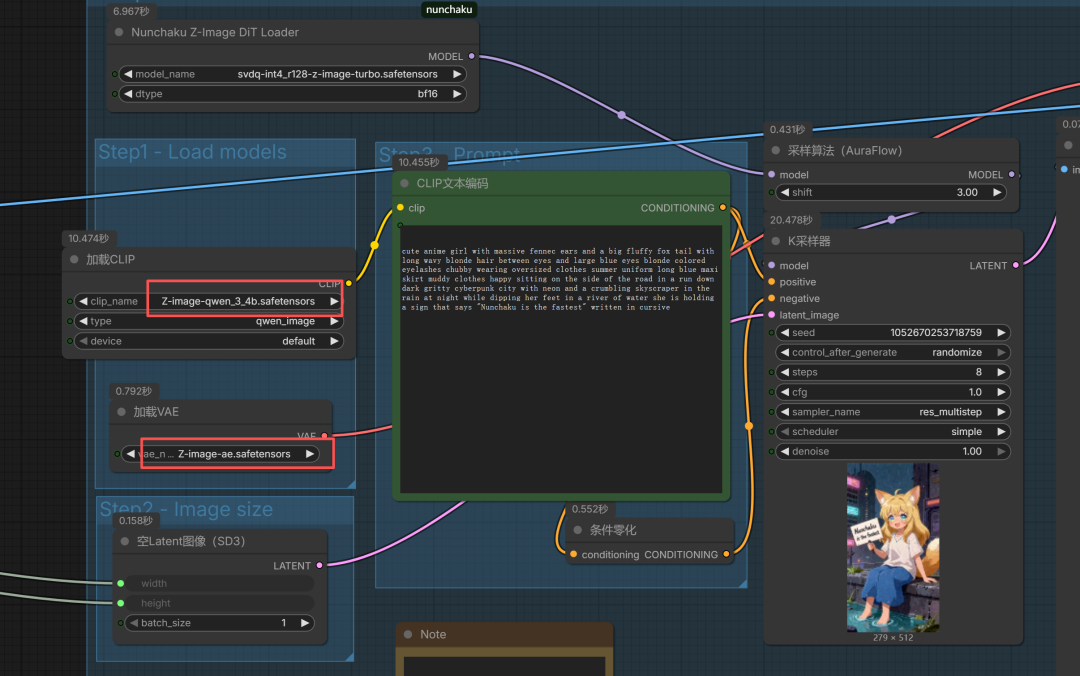

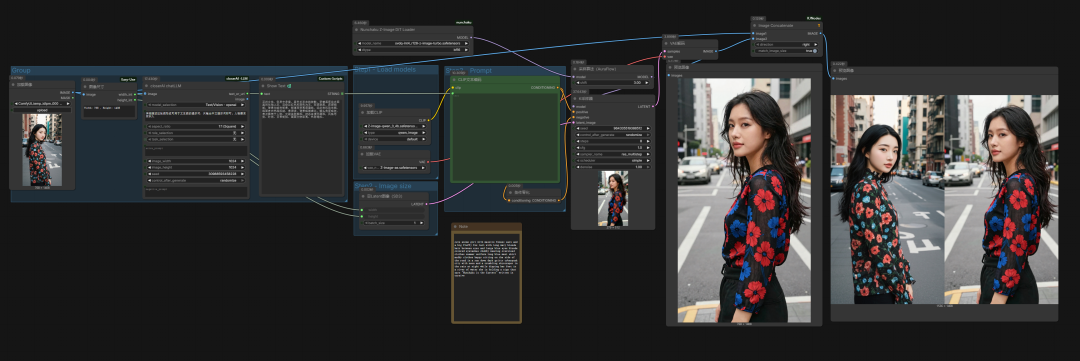

拖入工作流如下图示:

其中clip\VAE 都是用z-image原来的。

模型就用Nunchaku Z-Image DiT Loader加载器,

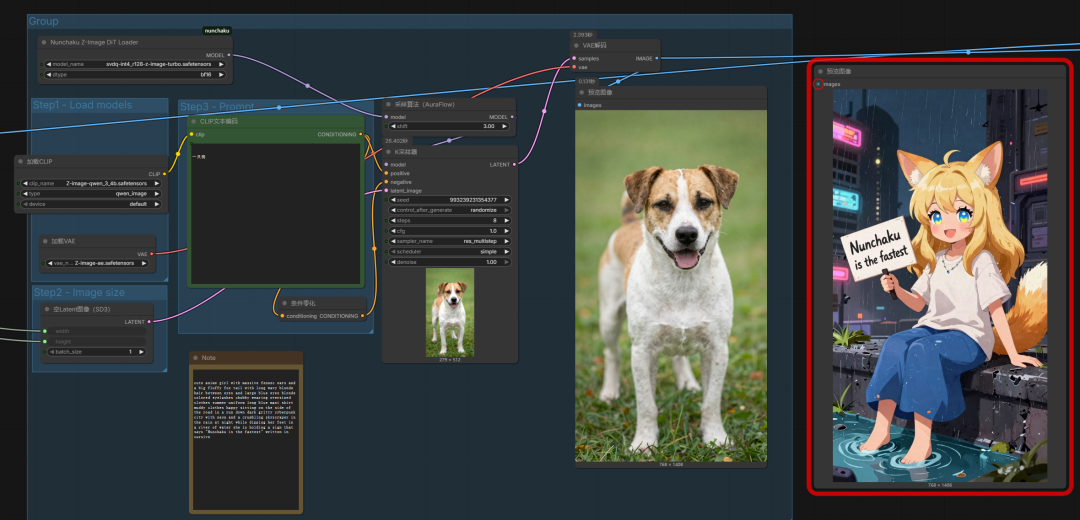

K采样器使用8步,1CFG,如图示。执行就行了。这样就能快乐抽卡了。

像我8G显存,平均30秒一张了。

大家自己评估自己的。

上面是nunchaku z-image文生图工作流。

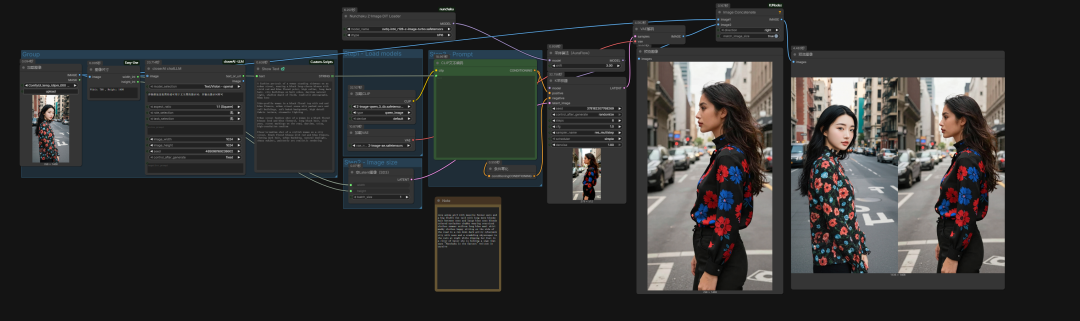

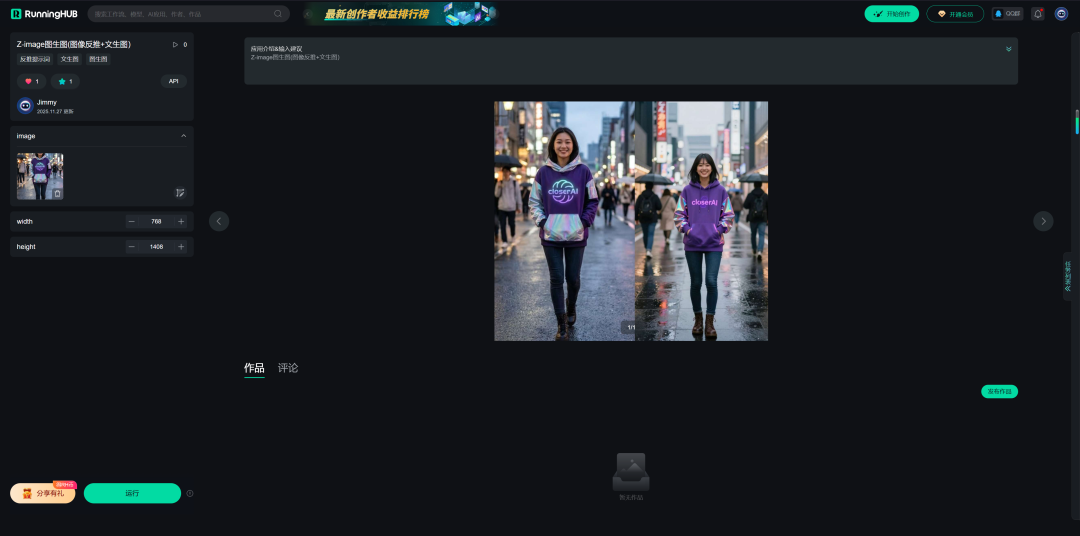

那图生图怎么操作呢?

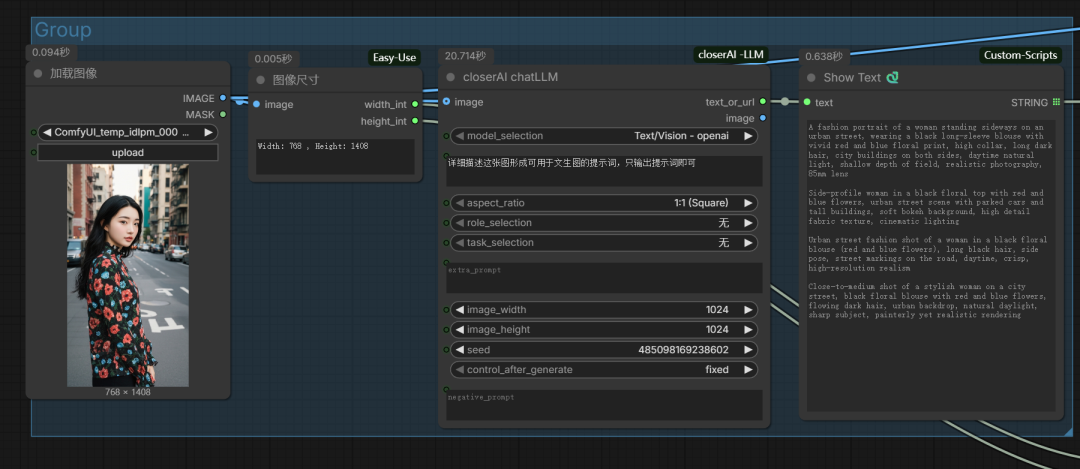

使用LLM对图像进行提示词反推。

这里选择多了,可使用qwen 3VL

也可使用第三方的。

这里我使用自己开发的ChatLLM节点。

以下是closerAI nunchaku z-image图生图工作流

1、ChatLLM进行图像提示词反推

2、nunchaku z-image生图

然后,这就是一整套z-image的nunchaku超高速图像生成工作流。

NSFW快乐出图。快去玩吧。

如果对你有帮助,请一键三连支持下我。谢谢。

本地算力不够怎么办?

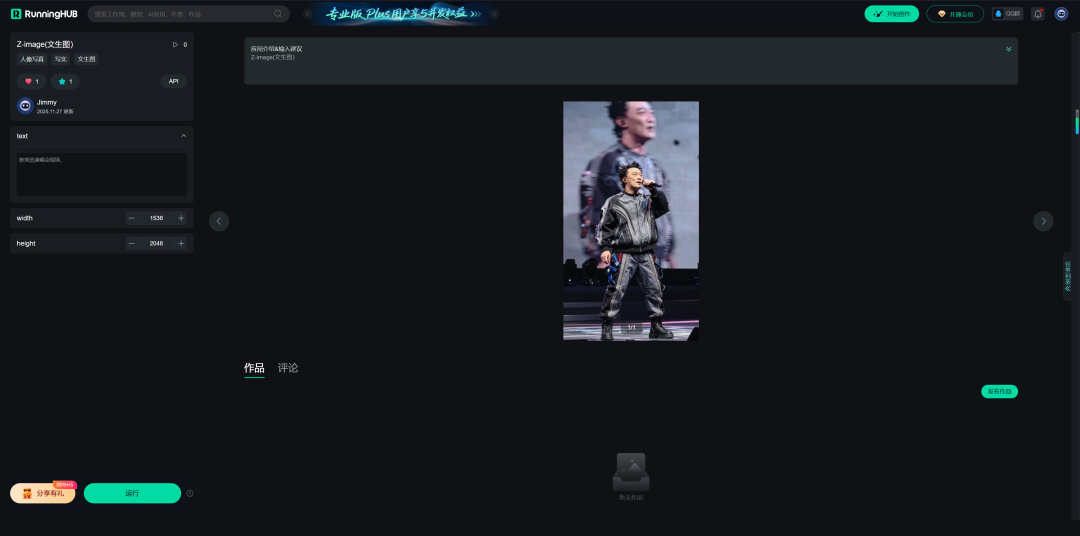

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

Z-image(文生图)应用体验地址:

Z-image(图生图)应用体验地址:

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

如果对你有帮助,请一键三连支持下我,感谢

closerAI-nanoPrompts:

http://closerai.douyoubuy.cn/2025/11/24/3396/

closerAI 分镜设计 软件(exe)本地运行版

http://aigc.douyoubuy.cn/2025/11/22/3350/

以下是closerAIwater节点:

http://aigc.douyoubuy.cn/2025/10/22/3121/

分镜分词器节点:

http://aigc.douyoubuy.cn/2025/10/11/3080/

json结构化提示词

http://aigc.douyoubuy.cn/2025/11/05/3242/

以上是closerAI团队制作的stable diffusion comfyUI closerAI开发的节点以及

closerAI nunchaku z-image工作流1222介绍,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)