更多AI前沿科技资讯,请关注我们:

超强!超高效!flux kontext dev最强组合完美工作流,nunchaku+自动循环+标注助手+提示词生成器+修复放大!

大家好,我是Jimmy。截至目前,kontext dev已出一周多时间,我们也深度围绕这个模型分享了很多实用技巧:能力释放!超准超快超高效,flux kontext最强组合:flux kontext+提示词助手+标注+nunchakku,完美

flux kontext dev 实现ID一致性的人物多姿势编辑,搭配循环助手解锁摄影写真、故事场景、短剧分镜等场景下的人物塑造

目前我们工作流不断迭代,已经实现了:

1、自动循环加载图像,多轮图像编辑;(循环节点助力的结果)

2、配合标注助手释放kontext视觉提示能力;(标注助手节点助力的结果)

3、配合提示词生成器,减少输入且形成kontext规则提示词;(kontext提示词生成器节点助力的结果)

4、高效的高清修复方案;(nunchaku版本放大模型的助力的结果)

有小伙伴提出修复方案能否再增加TTP,是的,的确TTP是目前最优的修复放大方案。所以这期,我们讲讲两种经典的放大修复方案。对比下,大家就能根据自己情况去选择。

我也将两种方案的接入我们目前kontext最强组合工作流中。这样,在修复放大方面,就有了两种选择。

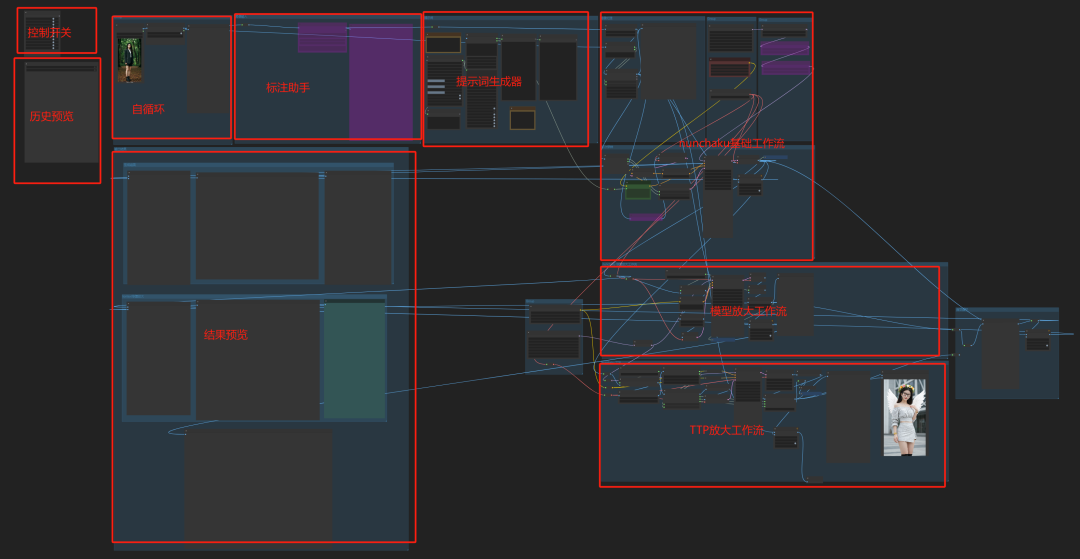

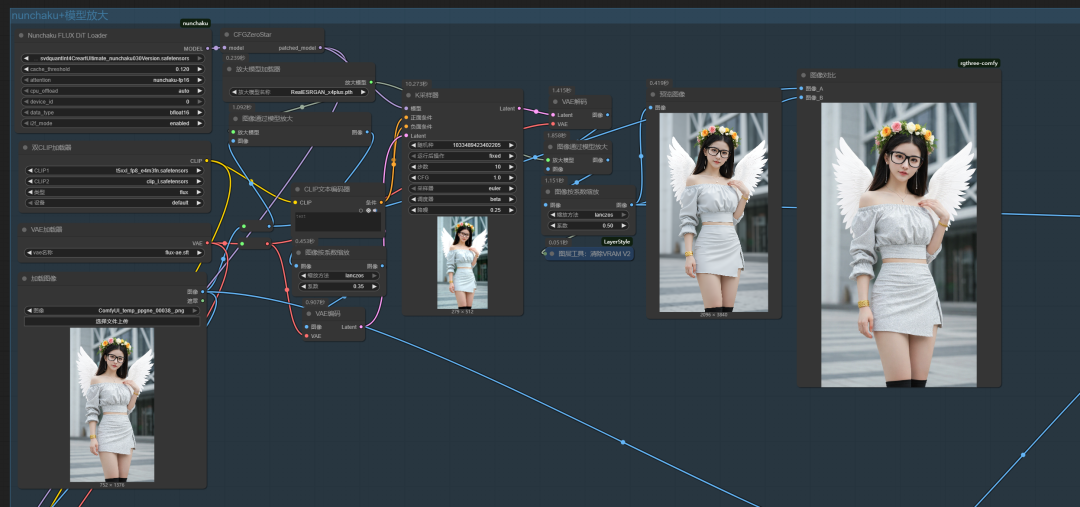

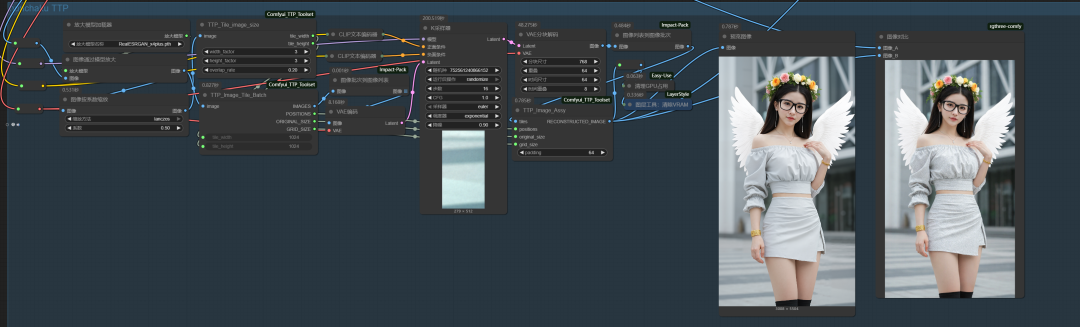

closerAI kontext 单图编辑工作流(nunchaku两种放大修复)如下:

其实工作流不复杂。只是看上去多内容而已。我标注好每个模块的工作内容了。其实大家使用时,只需要选择修复方式,其它无脑执行。若需要使用视觉提示功能,打开标注助手进行标注即可。

这里,重点讲修复放大,因为我们大多数人的本地设备不好,8G、16G其中16G占大多数了,一些优秀的修复项目如ComfyUI-SUPIR 24G才能玩。所以像这类的我们基本不考虑了。我要从效率和效果质量这两个维度出发,结合nunchaku对flux模型以及社区一些变体的放大模型来考虑我们的修复放大方案,以及一些轻量级专用修复模型Real-ESRGAN(放大去噪)来实现。

以下内容很干很实用,如果觉得不错,记得给我一键三连支持下啊,谢谢额!

我整理出了两种方法:

第一种是nunchaku放大模型+Real-ESRGAN模型的方法。

第二种是nunchaku放大模型+TTP分块放大的方法。

一、nunchaku放大模型+Real-ESRGAN模型修复放大法

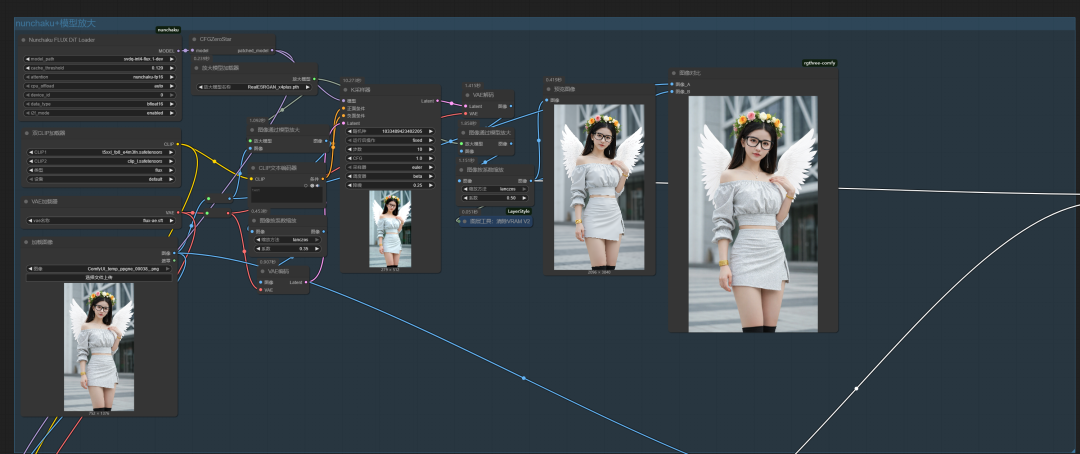

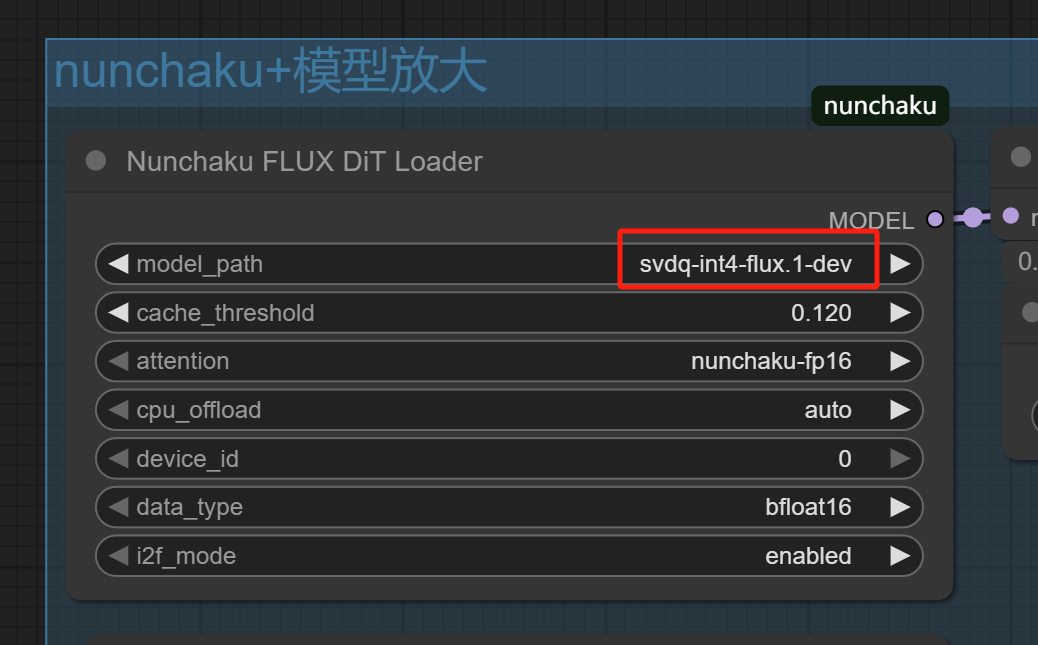

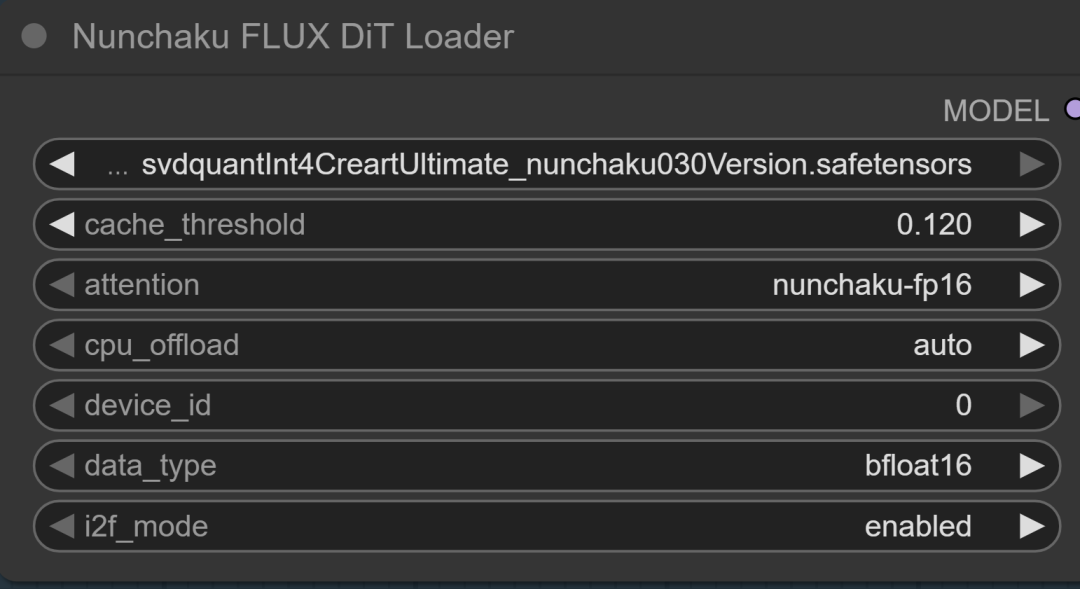

可使用nunchaku两个模型,一个是svdq-int4-flux.1-dev,一个是前天教程讲到的nunchaku变体版放大模型:

超赞超吊超无敌!flux nunchaku kontext高效修复放大方案,减少损失,配合循环助手,实现低损失对话式图像编辑!冲

国外一个大佬支持的nunchaku放大模型,这个模型是支持nunchaku0.3的,下载后放models/unet下:

模型:https://civitai.com/models/1545303?modelVersionId=1861654

放大模型:https://huggingface.co/uwg/upscaler/blob/main/ESRGAN/4x_NMKD-Siax_200k.pth

下载后放置models/upscale_models下

这里的cache_threshold值设置成0.12,我们做下加速,设置成0也没问题的。

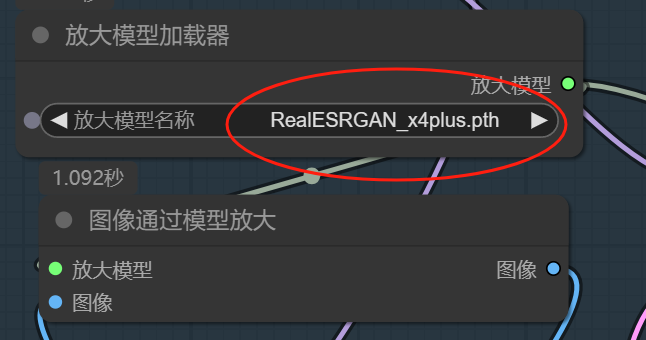

放大模型:我们选择realESRGAN_X4plus.pth 放大4倍哦!

然后K采样器的降噪值:设置成0.25。0.2~0.4也没问题,主要是控制重绘幅度,太大会改变原图。

我们加载一张图看看效果:以下是上次演示标注助手节点生成的图。

【closerAI ComfyUI】厉害!再次解锁:flux kontext的区域标注和涂鸦编辑功能!让脑洞更大!释放更多玩法!

我们无从浏览大放大来看看它未修复放大前的样子:

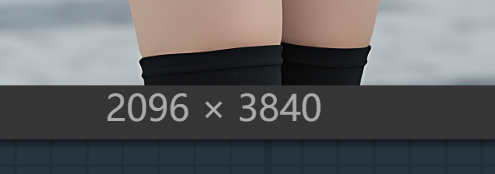

经过工作流的修复放大后:

这次我还是搞个视频大家看清楚点:

我们能清楚看到,去噪且放大,直接去到2K多。

这个方法,就是快,效率快,质量好。

所以这是我之前工作流推荐大家使用的方法。

但是呢,这也不是质量最好的,因为我们可以见它放大到最大时,没有细节。

那这个时候,TTP分块放大就是很好的方法了,分块若干块,每一块进行重绘。保证细节。如果你使用flux版的TTP放大,24G显存没个30~40分钟,你跑不出一张图。但是,nunchaku FLUX 版就很好地在效率上为我们解决了这个事nunchaku+TTP修复放大。

二、nunchaku放大模型+TTP分块放大法

同样在nunchaku模型选择,上面两个依旧二选一即可。

放大模型同样是realESRGAN 4倍:

K采样器设置如下图示:

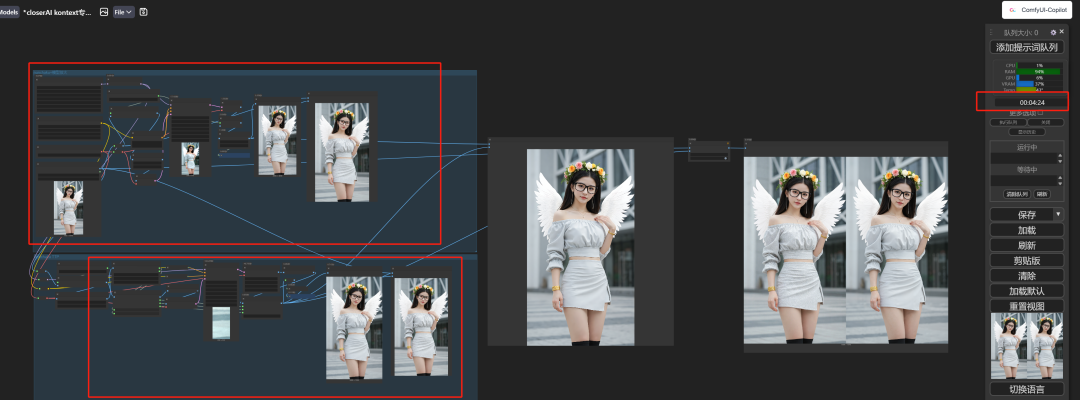

我们同样上面的图,运行下:

我再录个视频:

可见,它不会像上面那种方法,它会有细节,更真实。

但效率上比第一种方法慢点,但效果我个人觉得是好一点的。

三、两种方法结果对比

最后我将两种方法的结果,录个视频,这样更直观:

这样更直观,大家看看效果,根据自己本地设备配置选择对应方法。

我8G只能追求第一种结果了。哈哈。时间上呢,我两个工作流一起跑,一共才4分多钟。

以上就是关于修复方案的两种方法的详细介绍。

本地算力不够怎么办?

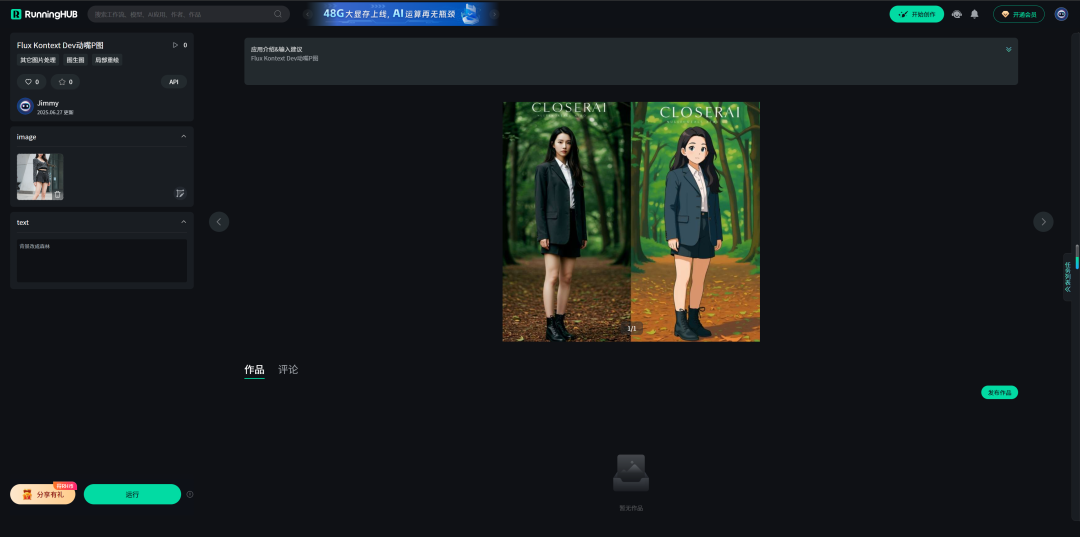

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

Flux Kontext Dev动嘴P图流体验地址:

https://www.runninghub.cn/ai-detail/1938445554957639681

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

超强!超高效!flux kontext dev最强组合完美工作流,nunchaku+自动循环+标注助手+提示词生成器+修复放大!真正无损的多轮图像编辑工作流,无限循环动嘴P图开启高效AIGC制作。让你高效出片!

以下是我开发的节点,配合kontext能高效出片:

1、comfyUI kontext 标注助手节点:

http://closerai.douyoubuy.cn/2025/07/01/2089/

2、comfyUI kontext提示词生成器节点:

http://aigc.douyoubuy.cn/2025/06/30/2062/

3、closerAI 图像循环助手节点:

http://aigc.douyoubuy.cn/2025/07/05/2137/

comfyUI kontext提示词生成器网页应用:

http://aigc.douyoubuy.cn/closerai-flux-kontext/

以上是closerAI团队制作的stable diffusion comfyUI closerAI开发的节点以及

closerAI kontext 对话式多轮单图编辑修复放大工作流介绍,大家可以根据工作流思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)